FPGA vs. Mikrocontroller – dieser Vergleich taucht immer dann auf, wenn Projekte schneller, präziser oder flexibler werden sollen als es klassische Embedded-Lösungen erlauben. Auf den ersten Blick wirken beide Technologien ähnlich, weil sie häufig in denselben Bereichen auftauchen: Steuerungen, Signalverarbeitung, Industrie, Robotik, Kommunikation, Mess- und Medizintechnik. In der Praxis verfolgen sie jedoch grundverschiedene Ansätze. Ein Mikrocontroller führt ein Programm Schritt für Schritt aus – so, wie man es aus C/C++ oder MicroPython kennt. Ein FPGA hingegen wird zur Hardware, die Sie sich nach Bedarf „zusammenbauen“: Logik, Datenpfade und Zustandsmaschinen laufen parallel und oft mit sehr deterministischen Laufzeiten. Das klingt nach einer klaren Überlegenheit des FPGA, ist aber zu kurz gedacht. Denn Mikrocontroller sind günstiger, schneller produktiv einzusetzen, energieeffizient und durch große Ökosysteme extrem praxisnah. FPGAs punkten, wenn höchste Parallelität, sehr niedrige Latenzen, besondere Schnittstellen oder maßgeschneiderte Hardware-Logik erforderlich sind. Wer die Unterschiede versteht, entscheidet besser: Welche Plattform passt zum Problem, welche zur Umgebung, welche zum Budget und zur Wartbarkeit? Dieser Artikel erklärt die wesentlichen Unterschiede zwischen FPGA und Mikrocontroller – verständlich, aber mit genug Tiefe, um typische Fehlentscheidungen zu vermeiden.

Grundprinzip: Prozessor-Software vs. rekonfigurierbare Hardware

Der wichtigste Unterschied liegt im Rechenmodell. Ein Mikrocontroller ist ein kleiner Computer auf einem Chip: Er besitzt CPU-Kerne, Speicher und Peripherie. Sie schreiben Software, die auf der CPU läuft. Ein FPGA (Field Programmable Gate Array) besteht aus vielen konfigurierbaren Logikblöcken, Schaltern und Verbindungsnetzen. Sie programmieren nicht „Software“, sondern konfigurieren die Hardware-Struktur, die anschließend als Schaltung arbeitet.

- Mikrocontroller: sequentielle Programmausführung auf einer CPU (Instruktion für Instruktion)

- FPGA: parallele Hardware-Logik, die gleichzeitig viele Aufgaben ausführen kann

- Konsequenz: „Mehr Takt“ beim Mikrocontroller ist nicht dasselbe wie „mehr Parallelität“ beim FPGA

- Praxis: Viele Probleme sind mit Software einfacher lösbar, andere profitieren massiv von Hardware-Parallelität

Für eine technische Einordnung bietet Mikrocontroller sowie Field-Programmable Gate Array (FPGA) einen Überblick.

Programmierung: C/C++ und Bibliotheken vs. HDL und digitale Logik

Bei Mikrocontrollern ist die Entwicklung typischerweise softwareorientiert: C/C++, Rust oder MicroPython, dazu Treiberbibliotheken und Frameworks. Debugging läuft über Serial Logs, JTAG/SWD und IDE-Werkzeuge. Beim FPGA arbeiten Sie dagegen häufig mit Hardwarebeschreibungssprachen (HDL) wie VHDL oder Verilog. Auch höhere Ebenen existieren (z. B. High-Level Synthesis), doch das Grundkonzept bleibt: Sie beschreiben Schaltungen, nicht Abläufe.

- Mikrocontroller-Toolchain: Compiler, Linker, Debugger, Firmware-Flash

- FPGA-Toolchain: Synthese, Place & Route, Timing-Analyse, Bitstream-Generierung

- Denkmuster: Algorithmus und Kontrollfluss vs. Datenpfade, Zustände und Parallelität

- Fehlerarten: Software-Bugs vs. Timing-Probleme, Metastabilität, falsche Takt-Domänen

Warum „einfach portieren“ selten funktioniert

Ein Algorithmus, der auf einem Mikrocontroller in einer Schleife läuft, lässt sich nicht 1:1 in ein FPGA übertragen. Im FPGA müssen Sie überlegen, welche Schritte parallel laufen, wie Daten gepuffert werden, wie viele Takte ein Pfad benötigt und wie die Synchronisation zwischen Taktdomänen passiert. Umgekehrt ist FPGA-Logik oft nicht sinnvoll als reine Firmware abzubilden, wenn man nur „ein bisschen schneller“ sein will.

Parallelität und Latenz: Der häufigste Grund für FPGAs

FPGAs sind besonders stark, wenn viele Operationen gleichzeitig passieren müssen oder wenn sehr geringe, konstante Latenzen entscheidend sind. Ein Mikrocontroller kann zwar Interrupts nutzen, DMA einsetzen und mehrere Peripherien bedienen – aber er bleibt oft an sequentielle Abarbeitung und Scheduling gebunden. Beim FPGA können Sie mehrere Datenpfade wirklich parallel aufbauen: Verarbeitung, Filterung, Protokollhandling und IO-Logik laufen gleichzeitig.

- Deterministische Latenz: konstante Reaktionszeiten, wenn Timing sauber geschlossen ist

- Massiv parallel: mehrere Kanäle oder Operationen gleichzeitig, ohne Kontextwechsel

- Streaming: Daten können „im Fluss“ verarbeitet werden, ohne große CPU-Last

- Beispielbereiche: schnelle Bild-/Signalverarbeitung, Hochgeschwindigkeits-I/O, Echtzeit-Encoder/Decoder

Wann ein Mikrocontroller trotzdem „echt genug“ ist

Viele Steuerungsaufgaben benötigen keine Nanosekunden-Latenzen. Wenn Sie Sensoren im Millisekundenbereich lesen, Relais schalten oder Protokolle wie Modbus/RS485 bedienen, sind Mikrocontroller meist ausreichend – oft sogar besser, weil der Entwicklungsaufwand geringer ist.

Peripherie und Schnittstellen: Fertige Hardware vs. frei definierbare Logik

Mikrocontroller bringen typische Peripherie direkt mit: UART, I2C, SPI, ADC, PWM, Timer, USB (je nach Modell), CAN, Ethernet (teilweise) und vieles mehr. Diese Blöcke sind „fertig“ und stabil, dafür aber in ihren Möglichkeiten begrenzt. Im FPGA können Sie Schnittstellen selbst implementieren oder als IP-Blöcke nutzen. Das eröffnet enorme Flexibilität: proprietäre Protokolle, spezielle Timing-Anforderungen, ungewöhnliche Busbreiten oder parallele Interfaces lassen sich anpassen.

- Mikrocontroller: sofort nutzbare Peripherie, sehr gute Dokumentation, klare Grenzen

- FPGA: flexible I/O-Architektur, anpassbare Protokolle, viele parallele Kanäle möglich

- Trade-off: Flexibilität kostet Entwicklungszeit und Validierungsaufwand

- Hybrid: Häufig übernimmt der Mikrocontroller „Management“, das FPGA die schnelle Datenarbeit

Leistung: „Schneller“ ist nicht nur MHz

Beim Vergleich der Rechenleistung wirken Mikrocontroller zunächst im Vorteil, weil man MHz, MIPS oder Benchmarks kennt. Bei FPGAs ist die Leistung anders zu bewerten: Entscheidend sind Parallelität, Pipeline-Tiefe und verfügbare Logikressourcen. Ein FPGA kann bestimmte Aufgaben um Größenordnungen schneller ausführen, wenn sie parallelisierbar sind (z. B. Filter auf mehreren Datenkanälen). Bei stark verzweigter Programmlogik, komplexen Datenstrukturen oder „Allzwecksoftware“ ist der Mikrocontroller oft effizienter – insbesondere, wenn ein moderner Cortex-M oder sogar ein Cortex-A/SoC im Spiel ist.

- FPGA-Stärken: parallelisierbare Algorithmen, feste Datenpfade, Hardware-Pipelines

- MCU-Stärken: Kontrolllogik, Protokoll-Stacks, UI, komplexe Zustände, flexible Updates

- DSP/Accelerator: Manche Mikrocontroller/SoCs haben DSP-Einheiten, die viele FPGA-Use-Cases abdecken

- Messkriterium: Durchsatz und Latenz pro Aufgabe statt „Taktfrequenz“

Stromverbrauch und thermische Aspekte

Für batteriebetriebene oder energieoptimierte Geräte sind Mikrocontroller oft die naheliegende Wahl. Sie besitzen ausgereifte Sleep-Modi, schnelle Wakeups und sehr niedrige Ruheströme. FPGAs können je nach Typ und Nutzung deutlich mehr Energie benötigen, insbesondere wenn viel Logik aktiv ist oder hohe Taktraten gefahren werden. Es gibt zwar Low-Power-FPGAs, aber die Energieeffizienz hängt stark vom Design ab: Ein „schlecht“ entworfenes FPGA-Design kann unnötig toggeln und damit Strom verschwenden, während ein gut pipeliniertes Design für bestimmte Aufgaben sehr effizient sein kann.

- Mikrocontroller: oft ideal für Low-Power, Sleep/Deep-Sleep, Duty-Cycling

- FPGA: Energiebedarf stark designabhängig, bei hoher Aktivität tendenziell höher

- Praktischer Punkt: Takt- und Clock-Gating sind beim FPGA ein zentrales Thema

- Systemdesign: Gesamtverbrauch hängt von Sensoren, Funk, Treibern und Netzteilen ab – nicht nur vom Rechenkern

Kosten und Stückzahlen: BOM, Entwicklungsaufwand und Zeit-to-Market

In vielen Projekten entscheidet nicht die theoretische Leistungsfähigkeit, sondern das Budget. Mikrocontroller sind in der Regel günstiger, leichter verfügbar und benötigen weniger Zusatzbauteile. FPGAs können teurer sein und oft kommen weitere Anforderungen hinzu: externe Konfiguration, schneller Speicher, hochwertigere Leiterplatten (Signalintegrität), aufwendigere Tests. Dazu kommt der Entwicklungsaufwand: FPGA-Entwicklung erfordert häufig mehr Spezialwissen und mehr Zeit, bis ein robustes Design steht.

- MCU-Vorteil: niedrige Stückkosten, schnelle Entwicklung, große Community

- FPGA-Vorteil: kann teure Spezial-ASICs ersetzen, flexibel für Varianten

- Engineering-Kosten: bei FPGAs oft höher, amortisieren sich aber bei passenden Use-Cases

- Risiko: Toolchain- und Timing-Probleme können Projekte verzögern

Wenn Flexibilität Geld spart

Ein FPGA kann wirtschaftlich sein, wenn Sie viele Varianten einer Hardwareplattform benötigen oder Protokolle/Standards sich ändern. Statt neue Hardware zu entwickeln, passen Sie die Logik an. In langlebigen Industrieprodukten kann das ein echter Vorteil sein.

Determinismus, Echtzeit und Zuverlässigkeit

Ein häufiges Argument für FPGAs ist „harte Echtzeit“. Durch feste Hardwarepfade sind Reaktionszeiten sehr konstant. Mikrocontroller können ebenfalls echtzeitfähig sein, besonders mit einem RTOS oder sorgfältig geschriebenem Bare-Metal-Code. Allerdings können Interrupts, Cache-Effekte (bei größeren CPUs), konkurrierende Tasks und Treiberlatenzen zu Jitter führen. In vielen Anwendungen ist das unkritisch. In anderen – etwa präziser Motorregelung mit sehr hoher Frequenz, High-Speed-Messsystemen oder deterministischer Protokollumsetzung – zählt jedes Mikrosekundenfenster.

- FPGA: sehr deterministisch bei sauberer Takt- und Timingplanung

- MCU: gut echtzeitfähig, aber stärker von Softwarearchitektur abhängig

- Fehlerszenarien: MCU kann hängen (Watchdog hilft), FPGA-Logik ist „hart verdrahtet“, aber Fehl-Design bleibt Fehl-Design

- Wartbarkeit: Software-Updates sind bei MCUs meist einfacher als HDL-Änderungen

Entwicklungsworkflow und Debugging: Was fühlt sich „einfach“ an?

Für viele Teams ist nicht die Hardware das Problem, sondern die Entwicklungsrealität. Mikrocontroller-Entwicklung ist etabliert: IDE, Breakpoints, Logging, Unit-Tests, CI/CD, OTA-Updates. FPGA-Entwicklung ist stärker hardwarezentriert: Simulation (Testbenches), Timing-Constraints, Logikanalysatoren, On-Chip-Debug (ILA/Logic Analyzer), sowie der Build-Prozess, der deutlich länger dauern kann als ein Firmware-Compile. Das ist nicht schlechter, aber anders – und erfordert eine passende Organisation.

- MCU-Debug: Breakpoints, Watch-Variablen, Serial Monitor, schnelle Iterationen

- FPGA-Debug: Simulation vor Hardware, Timingchecks, Signalbeobachtung mit Logic Analyzer

- Build-Zeiten: FPGA-Synthese kann Minuten bis Stunden dauern, je nach Design

- Fehlersuche: oft stärker „systemisch“ (Takt, Constraints, IO-Standards)

Simulation: Der größte Qualitätsschub bei FPGAs

Wer FPGA-Design ernsthaft betreibt, simuliert. Simulation reduziert das Risiko, weil viele Fehler sichtbar werden, bevor Hardware beteiligt ist. Das ist eine andere Denkweise als bei vielen Mikrocontroller-Projekten, die oft „direkt auf dem Board“ getestet werden.

Typische Einsatzfälle: Wann welches System besser passt

Der schnellste Weg zu einer guten Entscheidung ist ein Blick auf typische Muster. Mikrocontroller eignen sich hervorragend für Steuerung, Kommunikation, einfache Regelungen, Sensorik und Aktorik. FPGAs sind stark bei Hochgeschwindigkeit, Parallelität, kundenspezifischen Schnittstellen und deterministischen Datenpfaden. In vielen professionellen Produkten arbeiten beide zusammen: MCU für Konfiguration, Sicherheit, Kommunikation nach außen; FPGA für schnelle Datenerfassung und -verarbeitung.

- Mikrocontroller: Smart-Home-Steuerungen, IoT-Sensorik, Datenlogger, Motorsteuerungen (mittel), Protokoll-Gateways

- FPGA: schnelle Kamerainterfaces, SDR/Funk-Datenpfade, industrielle Hochgeschwindigkeitsmesstechnik, Protokollkonverter mit harter Echtzeit

- Hybrid: Messsysteme mit MCU-Frontend und FPGA-Backend, Robotik-Controller mit Echtzeit-Pipelines

- Alternative: SoCs (z. B. Linux-fähig) decken manches ab, was früher FPGA-only war

Wartung und Lebenszyklus: Updates, Sicherheit, Langzeitverfügbarkeit

In produktiven Systemen zählen Wartbarkeit und Lebenszyklus. Mikrocontroller-Firmware lässt sich sehr gut aktualisieren (auch „Over-the-Air“), und Sicherheitskonzepte wie Secure Boot und signierte Updates sind verbreitet. Beim FPGA ist ein Update ebenfalls möglich (Bitstream-Update), doch der Prozess ist oft vorsichtiger zu gestalten, weil ein fehlerhafter Bitstream das Gerät unbrauchbar machen kann, wenn kein Fallback existiert. Auch die Qualifikation der Toolchain-Versionen spielt eine Rolle: In Industrieprojekten ist es üblich, Toolchain und Design langfristig „einzufrieren“.

- MCU-Updates: etabliert, gut automatisierbar, oft mit Bootloader-Strategien

- FPGA-Updates: möglich, aber erfordert robuste Fallback-Mechanismen

- Toolchain-Stabilität: bei FPGAs häufig kritischer als bei MCUs

- Verfügbarkeit: MCU-Familien sind oft breit aufgestellt, bei FPGAs ist die Auswahl stärker herstellerspezifisch

Entscheidungshilfe: Fragen, die zur richtigen Wahl führen

Statt „FPGA ist besser“ oder „Mikrocontroller reicht immer“ lohnt ein strukturierter Fragenkatalog. Damit kommen Sie meist schnell zu einer belastbaren Entscheidung. Wichtig ist, ehrlich zu bewerten, welche Anforderungen wirklich hart sind und welche „nice to have“.

- Wie viel Parallelität brauche ich? Mehrere Kanäle gleichzeitig, echtzeitkritische Datenpfade?

- Welche Latenz ist akzeptabel? Mikrosekunden, Millisekunden, oder nur „gefühlt schnell“?

- Welche Schnittstellen sind nötig? Standard-Peripherie genügt oder ist Spezial-IO erforderlich?

- Wie komplex ist die Logik? Viel Steuerlogik spricht eher für MCU, viel Datenstrom eher für FPGA

- Wie wichtig sind Kosten und Time-to-Market? Prototyp schnell vs. maximale Performance

- Wie sieht Wartung aus? OTA, Feld-Updates, sichere Fallbacks, Team-Know-how

Ein pragmatischer Ansatz: Erst MCU, dann gezielt beschleunigen

In vielen Teams ist es sinnvoll, mit einem Mikrocontroller zu starten, Anforderungen real zu messen und erst dann auf FPGA zu wechseln, wenn klare Engpässe nachweisbar sind. Umgekehrt kann bei eindeutig datengetriebenen Hochgeschwindigkeitsanforderungen ein FPGA von Beginn an die bessere Wahl sein.

Outbound-Ressourcen zur Vertiefung

- Mikrocontroller: Aufbau, Aufgaben und typische Peripherie

- FPGA: Prinzip der rekonfigurierbaren Logik

- VHDL: Hardwarebeschreibungssprache für FPGA-Design

- Verilog: HDL-Grundlagen und Einsatz

- High-Level Synthesis: FPGA-Entwicklung auf höherer Abstraktionsebene

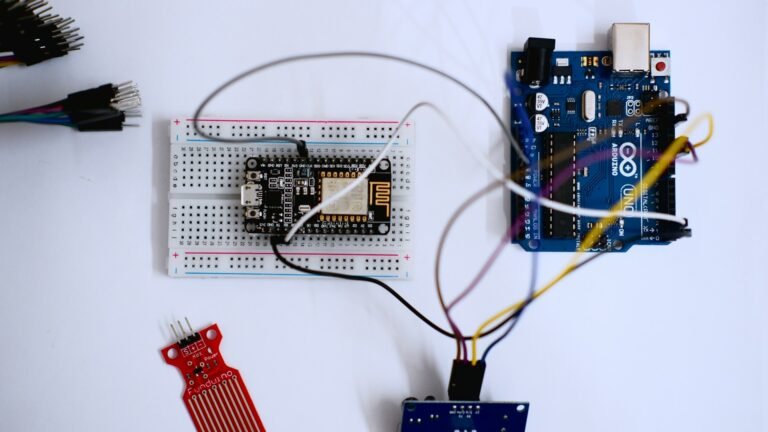

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.