Ein API-Gateway-Error wirkt im Incident häufig wie ein „einzelnes“ Problem – in Wirklichkeit ist er oft nur die sichtbare Oberfläche eines Fehlers, der in ganz unterschiedlichen Schichten entstehen kann: von einem instabilen Link (Layer 1) bis zu einer falschen Authentifizierung oder einem fehlerhaften Request-Format (Layer 7). Für ein NOC- oder Ops-Team ist deshalb nicht die Frage „Wer ist schuld?“, sondern: Welche Symptome passen zu welcher OSI-Schicht, und welches Owner-Team ist als Nächstes dran? Wenn Sie Symptome systematisch auf das OSI-Modell mappen, verkürzen Sie die Triage drastisch: Sie sammeln zielgerichtete Telemetrie, reduzieren Blindflüge (z. B. „mal DNS prüfen“) und geben Upstream-Teams klare, verwertbare Hinweise. Dieser Artikel zeigt einen praxistauglichen Ansatz, wie Sie typische API-Gateway-Fehlerbilder (z. B. 502/503/504, TLS-Handshake-Fehler, Timeouts, Rate Limits, Auth-Fehler) in OSI-Schichten übersetzen – inklusive konkreter Indikatoren aus Logs, Metriken und Testanfragen. Das Ergebnis ist eine wiederholbare Incident-Routine, die Einsteiger schnell sicher macht und Profis schneller zur Root-Cause-Hypothese führt.

Warum das OSI-Mapping bei API-Gateway-Errors so gut funktioniert

Ein API-Gateway sitzt „oben“ im Stack (meist Layer 7), kann aber Signale aus fast allen Schichten nach oben durchreichen. Ein Timeout kann Transport (Layer 4), Routing (Layer 3) oder Upstream-Überlast (Layer 7) bedeuten. Ein 502 kann „Upstream down“ heißen, aber ebenso „TLS zum Backend gebrochen“ oder „falsches SNI“ – je nach Architektur. Das OSI-Mapping zwingt die Triage zu einer klaren Reihenfolge:

- Symptom klassifizieren (z. B. „Handshake Failure“, „Connection refused“, „504“, „sporadisch nur manche Clients“).

- OSI-Schicht ableiten (welche Schichten sind plausibel, welche sind unwahrscheinlich?).

- Minimaldaten sammeln (genau die Messpunkte, die die Hypothese bestätigen oder widerlegen).

- Owner-Team bestimmen (Netzwerk/Edge, Security, Plattform, Application, IAM).

Das Ziel ist nicht akademisch, sondern operativ: schneller „Fault Domain“ bestimmen (Underlay vs. Overlay, Gateway vs. Backend, Client-spezifisch vs. global).

Vorbereitung: Ein einheitliches Symptom-Set fürs Ticket

Bevor Sie auf OSI mappen, braucht jedes API-Gateway-Incident-Ticket ein Mindestset an Fakten. Ohne diese Basis ist jede Zuordnung unsauber, weil entscheidende Kontexte fehlen (z. B. nur bestimmte Regionen betroffen).

- Betroffene API: Hostname, Pfad/Route, Methode (GET/POST/…), optional Tenant/Customer-Segment.

- Fehlerbild: Statuscode (z. B. 502/503/504/401/403/429), Fehlermeldungstext (Gateway-Message), Häufigkeit.

- Scope: Welche Regionen/ISPs/Client-Typen? Seit wann? Gibt es korrelierende Deployments/Changes?

- Reproduzierbarkeit: sporadisch oder konstant? Nur bei Payload X oder ab Größe Y?

- Messpunkte: mindestens ein Request-ID/Trace-ID, plus Zeitfenster.

Mit diesen Daten können Sie die Symptome sauber den OSI-Schichten zuordnen und vermeiden, dass Teams „im Nebel“ suchen.

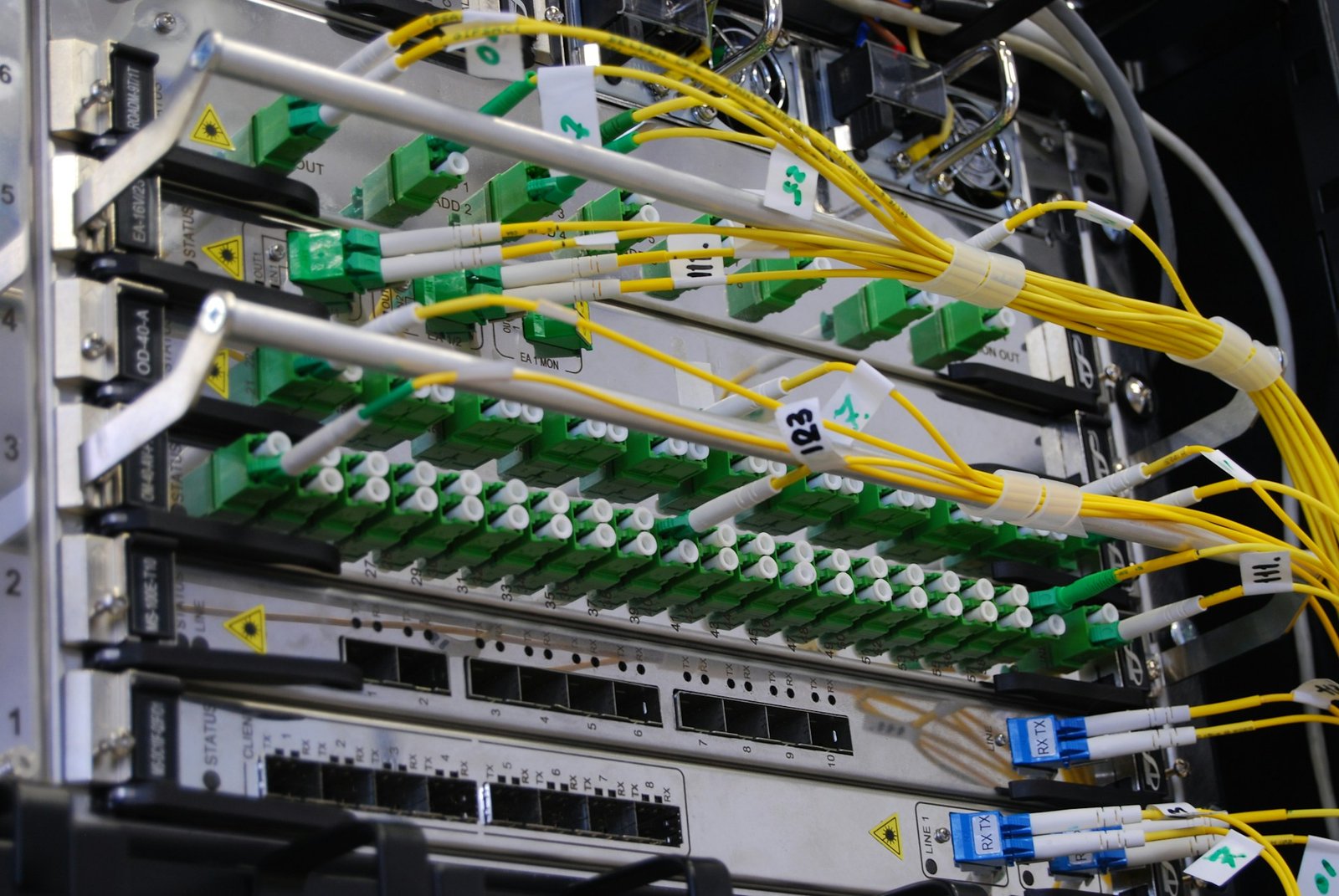

Layer 1: Physik und Link – selten, aber bei großen Störungen entscheidend

API-Gateways laufen meist in Rechenzentren oder Cloud-Edges; echte Layer-1-Probleme erscheinen deshalb nicht als „kaputtes Kabel“ im Ticket, sondern als Häufung von Paketverlust, Link-Flaps oder Interface-Errors auf Netzwerkkomponenten. Typische Layer-1-Symptome, die im Gateway als Error auftauchen können:

- Plötzliche, starke Error-Spikes (Timeouts, 5xx) in einer Zone/Region, oft zusammen mit Paketverlust.

- Kurze Aussetzer (Sekunden) mit schneller Erholung, wiederkehrend (Link-Flapping).

- Asymmetrische Ausfälle: nur ein Teil der Gateways/Pods betroffen, abhängig vom Rack/ToR.

Minimaldaten für Layer 1

- Zeitraum und betroffene Instanzen (Gateway-Node/Pod/VM), idealerweise Topologie-Hinweis (AZ, Rack, Cluster).

- Netzwerkmetriken: Interface Errors (CRC, FCS), Link Up/Down Events, Optical Power (bei Fiber).

- Gateway-Sicht: Spike in Connect-Timeouts oder Retransmissions (indirekt), gekoppelt an bestimmte Hosts.

Wenn diese Indikatoren passen, ist das Owner-Team meist Network/Datacenter/Infra – nicht die API-Entwicklung.

Layer 2: Switching, VLANs, Loops – wenn „Connectivity“ intermittierend wird

Layer-2-Probleme sind für API-Gateway-Errors tückisch, weil sie oft intermittierend auftreten und wie „random timeouts“ wirken. Broadcast-Storms, STP-Events oder VLAN-Mismatches können einzelne Segmente isolieren. Typische Symptome:

- Intermittierende Timeouts mit hoher Varianz (mal schnell, mal sehr langsam), oft auf Segment begrenzt.

- Gleichzeitige Probleme mehrerer Services in derselben Zone, weil das L2-Domain gemeinsam ist.

- MAC-Flapping oder STP-Topology Changes korrelieren zeitlich mit Gateway-Fehlern.

Minimaldaten für Layer 2

- Betroffene Subnetze/VLANs/AZs und konkrete Zeitfenster.

- Switch-Events: STP TCN, Port-Errdisable, MAC-Flap-Logs, Broadcast/Multicast-Rate.

- Gateway/Backend: Welche IPs sind nicht erreichbar? Ist ARP/Neighbor-Resolution auffällig?

Bei Layer 2 ist die Owner-Zuordnung meist Netzwerkbetrieb. Wichtig: L2-Probleme sind selten „nur eine API“ – sie betreffen typischerweise mehrere Dienste.

Layer 3: Routing, Reachability, DNS als „Wegweiser“ – aber nicht verwechseln

Layer 3 ist häufig die Grenze zwischen „Connectivity“ und „Service“. Routing-Blackholes, VRF-Isolation oder fehlerhafte Policies führen dazu, dass das Gateway Backends nicht erreicht – daraus entstehen 502/503/504, je nach Implementierung. Typische Layer-3-Symptome:

- Timeouts zu bestimmten Backend-IPs/Subnetzen, während andere Backends erreichbar bleiben.

- Traceroute stoppt an einem Hop (Blackhole) oder zeigt unerwartete Pfade.

- Nur bestimmte Regionen/ISPs betroffen (Peering/Transit), während interne Requests funktionieren.

Minimaldaten für Layer 3

- Betroffene Destinationen: Backend-IP(s), VIP(s), Subnetze, ggf. VRF/Segment.

- Mehrpunkt-Tests: Ping/Traceroute/MTR (oder Äquivalent) von Gateway zu Backend und umgekehrt.

- Routing-Table-Checks: existiert Route? stimmt Next-Hop? gibt es Policy/ACL-Hits?

Wichtig für die Triage: DNS ist nicht Layer 3, wird aber oft als „Netzwerk“ eingeordnet. DNS-Probleme äußern sich meist als „Hostname not resolved“ oder sehr lange Lookup-Zeiten – das ist operativ eher Layer 7 (Anwendungsprotokoll) mit Infrastruktur-Owner (DNS-Team).

Layer 4: TCP/UDP – „Timeout“ ist nicht gleich „Connection Refused“

Bei API-Gateways ist Layer 4 einer der häufigsten Ursprungspunkte für Missverständnisse. Ein 504 ist oft ein L7-Symptom, aber die Ursache kann L4 sein: SYN-Retransmits, fehlende Session-State auf Firewalls, NAT/Conntrack-Limits oder Idle-Timeouts. Typische L4-Symptome im Gateway-Kontext:

- Connection timeout (kein TCP-Handshake) oder gehäufte Retransmissions.

- Connection refused (Port geschlossen, Prozess down, falscher Service-Port, Security Group).

- RST-Spikes (Resets) zwischen Gateway und Upstream.

- Nur manche Clients betroffen, z. B. bei ECMP/Hashing oder stateful Middleboxes.

Entscheidungslogik: Timeout vs. Refused

- Timeout: oft Pfad/Firewall/Overload/Packetloss – Hinweis auf Netzwerkpfad, Policy oder Ressourcen.

- Refused: meist Service-Exposure/Listener/Port – Hinweis auf Backend/Plattform oder Security-Policy.

Minimaldaten für Layer 4

- Connect-Time (Gateway-Metrik), Reset/Timeout-Counts, Error-Reason (sofern Gateway sie loggt).

- Firewall/LB: Session-Table-Auslastung, Drops, Deny-Logs, Idle-Timeout-Policies.

- Backend: Lauscht der Port? Gibt es Listen-Queue-Overflow? Wurde ein Change am Service-Port gemacht?

Viele Gateways liefern bereits L4-nahe Felder wie „upstream connect time“, „upstream response time“ oder „tcp error reason“. Diese Felder sind für die Owner-Zuordnung entscheidend.

Layer 5: Session – wenn „einmal verbunden“ nicht stabil bleibt

Layer 5 wird im Alltag oft übersehen, ist aber bei Gateways relevant: Keepalive, Connection Pooling, HTTP/2-Multiplexing, Session Affinity und Sticky Sessions am Load Balancer können Fehlerbilder erzeugen, die wie reine L7-Probleme aussehen. Typische Session-Symptome:

- Plötzliche Spikes nach Inaktivität: erste Requests nach Idle schlagen fehl (Idle Timeout, NAT/Firewall).

- Nur bestimmte Requests betroffen, z. B. wenn ein Connection Pool auf eine „schlechte“ Upstream-Instanz klebt.

- Intermittierende Auth-/Session-Fehler bei Sticky-Session-Mechaniken (z. B. Cookies, Source-IP Affinity).

Minimaldaten für Layer 5

- Keepalive- und Idle-Timeout-Einstellungen (Gateway, LB, Firewall, Backend).

- Verbindungswiederverwendung: Anteil neuer Verbindungen vs. Reuse (Connection Reuse Rate).

- Hinweise auf Affinity: Session-Cookie, LB-Persistenz-Methoden, Consistent Hashing.

Layer 6: Presentation – TLS, Zertifikate, mTLS und „Handshake Failure“

Layer 6 ist in der Gateway-Welt praktisch gleichbedeutend mit TLS/SSL. Ein API-Gateway terminiert TLS häufig clientseitig und baut ggf. erneut TLS zum Backend auf (Re-Encryption) oder nutzt mTLS im Service Mesh. Typische Symptome:

- TLS handshake failure, certificate verify failed, unknown ca, bad certificate.

- Nur manche Clients: alte Cipher Suites, fehlende SNI-Unterstützung, Enterprise-Proxies.

- Spikes zu festen Zeiten: abgelaufene Zertifikate, OCSP/CRL-Probleme, Rotation fehlgeschlagen.

- 502/503 ohne Backend-Load-Spike: Gateway kann TLS zum Upstream nicht aufbauen, meldet generisches Upstream-Error-Symptom.

Minimaldaten für Layer 6

- Betroffener Hostname/SNI, TLS-Version, Cipher (falls logbar), Fehlertext aus Gateway/Client.

- Zertifikatsdaten: Ablaufdatum, Chain/Intermediate, SANs, ob mTLS aktiv ist.

- Vergleichsmessung: funktioniert HTTP (ohne TLS) intern? schlägt nur HTTPS fehl? nur Backends oder auch Clients?

Owner-Teams sind hier häufig Security/IAM (Zertifikate), Plattform (Ingress/LB), oder Service-Mesh-Owner (mTLS Policies).

Layer 7: Anwendung – HTTP-Status, Auth, Rate Limiting, Routing-Regeln

Die meisten sichtbaren API-Gateway-Errors sind Layer-7-Signale: HTTP-Statuscodes, Header-Validation, JWT-Prüfung, WAF-Regeln, API-Key-Policies, Quotas, Routing und Transformationen. Entscheidend ist, L7 weiter zu unterteilen: „Gateway-L7“ (Policies am Gateway) vs. „Backend-L7“ (Upstream-Anwendung). Typische Symptome:

- 401/403: AuthN/AuthZ, Token-Scopes, API-Key, mTLS-Client-Zertifikat fehlt, Policy-Block.

- 429: Rate Limiting/Quota; oft tenant- oder key-spezifisch.

- 400/413/414: Request-Validation, Payload zu groß, Header zu groß, URL zu lang.

- 502/503/504: kann Gateway (Upstream) oder Backend sein – hier müssen Sie Felder wie Upstream-Status, Retry-Count, Connect-Time heranziehen.

- Misroute: falscher Route-Match, falsches Host/Path-Rewrite, falsche Upstream-Cluster-Zuordnung.

Minimaldaten für Layer 7

- Statuscode + Gateway-Reason (z. B. „rate limited“, „upstream timeout“, „invalid token“) und Request-ID.

- Route/Service-Mapping: welcher Upstream-Cluster wurde gewählt? gab es Retries? welche Policy hat gegriffen?

- Client-Kontext: API-Key/JWT (nur Metadaten, keine Secrets), User-Agent, Region/ASN, Request-Size.

Mapping-Tabelle: Häufige API-Gateway-Fehlerbilder → OSI-Schicht

Die folgende Zuordnung ist als Triage-Hilfe gedacht. Ein Symptom kann mehrere Schichten betreffen – entscheidend ist, welche Daten es am schnellsten eingrenzen.

- „Name or service not known“, DNS timeout → meist Layer 7 (DNS) mit Infrastruktur-Owner (Resolver/Zone), nicht Layer 3.

- TCP connect timeout → häufig Layer 4, potenziell Layer 3 (Blackhole) oder Layer 2/1 (Instabilität).

- Connection refused → Layer 4 (Port/Listener/Policy), oft Backend/Plattform.

- TLS handshake failure / cert verify failed → Layer 6 (Zertifikate, mTLS, Cipher/SNI).

- 401/403 → Layer 7 (Auth/Policy/IAM).

- 429 → Layer 7 (Rate Limiting/Quota), selten L4-DDoS-Protection als Ursache.

- 502/503/504 → Layer 7 Symptom, Ursachen reichen von L4 (Timeout/Reset) über L6 (TLS zu Upstream) bis L7 (Backend-Overload/Misroute).

- Sporadisch nur manche Clients → oft Layer 3/4 (ECMP/ISP/Asymmetrie) oder Layer 6 (Client-TLS), seltener reines Backend.

Decision Tree für die Triage: In 5 Minuten zur plausiblen Schicht

Ein OSI-basiertes Vorgehen wird besonders stark, wenn Sie es als Decision Tree nutzen. Diese Reihenfolge minimiert Zeitverlust:

- 1) Ist es ein Namensproblem? Fehlermeldung deutet auf DNS, oder nur einzelne Domains betroffen.

- 2) Kommt TCP zustande? Connect-Timeouts vs. Refused vs. Resets (Layer 4/3).

- 3) Scheitert TLS? Handshake-/Zertifikatsfehler (Layer 6).

- 4) Ist HTTP korrekt, aber langsam/fehlerhaft? Statuscodes, TTFB, Upstream-Response-Time (Layer 7).

- 5) Ist es scope-begrenzt? Nur Region/ISP/Tenant → oft Policy, Routing oder Middlebox-Effekt.

Wenn Sie diese fünf Fragen beantworten, haben Sie in der Regel eine belastbare Erstzuordnung – und wissen, welche Logs/Metriken Sie als Nächstes brauchen.

Welche Telemetrie am Gateway „must have“ ist

Viele Teams verlieren Zeit, weil das Gateway zwar Daten hat, aber nicht standardisiert ausgibt. Für OSI-Mapping sind folgende Felder besonders wertvoll:

- Request-ID/Correlation-ID (und idealerweise Trace-ID): damit Upstream-Teams nachvollziehen können.

- Upstream connect time, upstream response time, TTFB: um L4/L7 zu trennen.

- Upstream status vs. gateway status: ob das Gateway selbst generiert hat oder vom Backend kam.

- Retry count, circuit breaker events: versteckte Retries enttarnen.

- TLS meta: SNI, TLS-Version, Handshake-Error-Reason (wenn möglich), mTLS-Policy-Result.

- Rate limit decision: welche Regel, welche Quote, welcher Key/Tenant (ohne Secrets).

Damit wird aus „API-Gateway-Error“ ein strukturierter Datensatz, den jedes Owner-Team sofort nutzen kann.

Outbound-Links für vertiefende, verlässliche Referenzen

- HTTP Semantics (RFC 9110) für Statuscodes, Request/Response-Semantik und saubere Interpretation von HTTP-Verhalten.

- HTTP/1.1 Semantics and Content (RFC 7231) als ergänzende Referenz für verbreitete HTTP-Status-Interpretationen in Bestandsumgebungen.

- TLS 1.3 (RFC 8446) für Handshake-Abläufe, Fehlerbilder und Performance-Aspekte.

- TCP (RFC 9293) für Transportfehler, Retransmissions und Handshake-Mechanik.

- OWASP API Security Project für typische API-Policy- und Auth-Fehlerbilder, die im Gateway sichtbar werden.

Cisco Netzwerkdesign, CCNA Support & Packet Tracer Projekte

Cisco Networking • CCNA • Packet Tracer • Network Configuration

Ich biete professionelle Unterstützung im Bereich Cisco Computer Networking, einschließlich CCNA-relevanter Konfigurationen, Netzwerkdesign und komplexer Packet-Tracer-Projekte. Die Lösungen werden praxisnah, strukturiert und nach aktuellen Netzwerkstandards umgesetzt.

Diese Dienstleistung eignet sich für Unternehmen, IT-Teams, Studierende sowie angehende CCNA-Kandidaten, die fundierte Netzwerkstrukturen planen oder bestehende Infrastrukturen optimieren möchten. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

Netzwerkdesign & Topologie-Planung

-

Router- & Switch-Konfiguration (Cisco IOS)

-

VLAN, Inter-VLAN Routing

-

OSPF, RIP, EIGRP (Grundlagen & Implementierung)

-

NAT, ACL, DHCP, DNS-Konfiguration

-

Troubleshooting & Netzwerkoptimierung

-

Packet Tracer Projektentwicklung & Dokumentation

-

CCNA Lern- & Praxisunterstützung

Lieferumfang:

-

Konfigurationsdateien

-

Packet-Tracer-Dateien (.pkt)

-

Netzwerkdokumentation

-

Schritt-für-Schritt-Erklärungen (auf Wunsch)

Arbeitsweise:Strukturiert • Praxisorientiert • Zuverlässig • Technisch fundiert

CTA:

Benötigen Sie professionelle Unterstützung im Cisco Networking oder für ein CCNA-Projekt?

Kontaktieren Sie mich gerne für eine Projektanfrage oder ein unverbindliches Gespräch. Finden Sie mich auf Fiverr.