Edge AI auf dem STM32 bedeutet, dass Machine-Learning-Modelle direkt auf einem Mikrocontroller laufen – ohne permanente Cloud-Anbindung und ohne leistungsstarke CPU im Hintergrund. Statt Rohdaten von Sensoren ständig zu übertragen, werden Signale lokal verarbeitet, klassifiziert oder auf Anomalien geprüft. Das ist für Industrie 4.0, Medizintechnik, Gebäudeautomation und mobile Geräte besonders attraktiv: Latenzen sinken, Bandbreite wird gespart, die Privatsphäre verbessert sich und viele Anwendungen bleiben auch bei Funkproblemen funktionsfähig. STM32-Mikrocontroller eignen sich dafür, weil sie ein breites Spektrum an Leistungs- und Stromsparklassen abdecken, robuste Peripherie für Sensorik und Kommunikation mitbringen und durch ein großes Ökosystem an Tools und Bibliotheken unterstützt werden. In diesem Artikel lernen Sie praxisnah, wie Sie Edge-AI-Workloads auf STM32 planen, Modelle optimieren, Speicherbudgets einhalten und die Inferenz zuverlässig in ein Embedded-System integrieren. Der Fokus liegt auf nachvollziehbaren Entscheidungsregeln: Wann lohnt sich ein neuronales Netz, wann reicht klassische Signalverarbeitung, welche Modellformate sind sinnvoll, und wie kommen Sie von einem Python-Modell zu stabil laufendem C-Code auf dem Chip?

Was ist Edge AI – und warum ist es mehr als „KI ohne Cloud“?

Edge AI beschreibt die Ausführung von KI- oder ML-Algorithmen direkt am Rand des Netzwerks, also auf dem Endgerät. In Embedded-Projekten ist das typischerweise ein Mikrocontroller, der Sensordaten erfasst und daraus lokale Entscheidungen ableitet. Im Gegensatz zu „Cloud AI“ steht nicht maximale Modellgröße im Vordergrund, sondern ein ausgewogenes Verhältnis aus Genauigkeit, Rechenzeit, Speicherbedarf und Energieverbrauch.

- Niedrige Latenz: Entscheidungen in Millisekunden, ohne Netzwerk-Trip.

- Datensparsamkeit: Nur Ereignisse oder Kennzahlen werden übertragen, nicht komplette Rohdatenströme.

- Robustheit: Das System arbeitet auch offline oder bei instabiler Verbindung.

- Privacy by Design: Sensible Daten müssen das Gerät nicht verlassen.

Genau diese Eigenschaften machen Edge AI für industrielle Anwendungen interessant: Zustandsüberwachung, Qualitätskontrolle, vorausschauende Wartung und intelligente Regelung profitieren von lokalem, deterministischem Verhalten.

Warum STM32 für Edge AI? Stärken, die im Feld zählen

STM32 ist keine einzelne Plattform, sondern eine Familie. Für Edge AI ist das hilfreich, weil Sie je nach Use Case vom extrem stromsparenden Sensor-Knoten bis zum leistungsfähigen Edge-Gateway skalieren können. Entscheidend sind dabei nicht nur Taktfrequenzen, sondern auch Peripherie, Speicherarchitektur und Tooling. Auf der Produktübersicht von ST sehen Sie die Bandbreite der STM32-Serien: STM32-Mikrocontroller (Übersicht).

Für KI auf Mikrocontrollern sind typischerweise diese Eigenschaften relevant:

- DSP-taugliche Rechenkerne: Arm Cortex-M mit effizienter Integer-Arithmetik, oft mit DSP-Erweiterungen.

- Deterministische Peripherie: Timer, ADC, DMA für wiederholbare Datenerfassung.

- Stromsparmodi: Duty-Cycling für batteriebetriebene Inferenz.

- Werkzeugkette: Integrierte Generierung/Optimierung von Inferenz-Code und Benchmarking.

Die Werkzeuglandschaft: ST Edge AI Suite, X-CUBE-AI und NanoEdge AI Studio

Ein großer Vorteil in der STM32-Welt ist, dass ST den Weg von trainierten Modellen zur Embedded-Integration stark vereinfacht. Die zentrale Anlaufstelle ist die ST Edge AI Suite, die Tools und Ressourcen bündelt.

X-CUBE-AI und STM32Cube.AI: Modelle in optimierten C-Code bringen

Für klassische neuronale Netze (z. B. CNNs für Audio/Visionsignale, kleine MLPs für Sensorfusion) wird häufig X-CUBE-AI genutzt. Dieses STM32Cube-Expansion-Paket dient dazu, Modelle zu evaluieren, zu optimieren und als STM32-optimierte Bibliothek zu generieren – inklusive Benchmarking und Validierung auf PC und Zielhardware. Laut ST unterstützt X-CUBE-AI verschiedene Frameworks und Formate (u. a. TensorFlow Lite, ONNX) und kann auf Hardwarebeschleunigung (z. B. NPU/Neural-ART Accelerator, sofern verfügbar) zurückgreifen oder ansonsten CPU-Fallback nutzen.

Die zugehörige Dokumentationssammlung im ST-Wiki bietet praktische Einstiege und Verweise auf UM-Dokumente: X-CUBE-AI Dokumentation (ST Wiki).

NanoEdge AI Studio: AutoML für Sensorik – schnell zu Anomalieerkennung und Klassifikation

Wenn Ihr Projekt primär Sensordaten auswertet (Vibration, Strom, Druck, Temperatur) und Sie keine großen Deep-Learning-Modelle einsetzen wollen, ist NanoEdge AI Studio besonders interessant. Der Fokus liegt auf Anomalieerkennung, Klassifikation und Regression mit minimalem Data-Science-Aufwand. ST beschreibt den Workflow als geführte Schritte zur Datensammlung, Validierung und Generierung einer C-Bibliothek. Eine anschauliche Übersicht finden Sie auch auf der STM32AI-Seite: NanoEdge AI (Workflow-Übersicht).

Modelltypen für Edge AI: Was passt zu STM32?

Edge AI ist nicht gleich Deep Learning. In vielen Embedded-Szenarien sind kompakte Modelle überlegen, weil sie weniger Speicher benötigen und besser deterministisch laufen. Typische Modellfamilien:

- Klassische ML-Modelle: SVM, K-Means, Isolation Forest – oft gut für Anomalien und einfache Klassen.

- Kleine neuronale Netze: MLPs für Sensorfusion, 1D-CNNs für Audio/Vibration, kleine 2D-CNNs für einfache Vision-Aufgaben.

- Hybridansätze: Signalverarbeitung (FFT/Filter) + kleiner Klassifikator.

Die wichtigste Frage ist: Welche Eingangsgröße haben Ihre Daten, und wie häufig muss entschieden werden? Ein Modell, das nur alle 200 ms laufen muss, hat ein ganz anderes Budget als eine Inferenz pro Millisekunde.

Speicherbudget realistisch planen: Flash, SRAM und „aktivierte“ Zwischenpuffer

Der häufigste Grund, warum Edge-AI-Prototypen auf einem Mikrocontroller scheitern, ist Speicherknappheit – nicht die Rechenzeit. Drei Speicherblöcke sind besonders wichtig:

- Gewichte (Weights): meist im Flash, bei quantisierten Modellen deutlich kleiner.

- Aktivierungen (Activations): Zwischenpuffer im SRAM; oft der größte RAM-Posten.

- Arbeitsbereich/Stack: zusätzlich zu RTOS, Treibern, Kommunikationsstacks.

Eine einfache Planungsregel ist, die Laufzeit- und Speicheranforderungen in einer Art „Budgetgleichung“ festzuhalten. So vermeiden Sie, dass die Inferenzbibliothek später die Applikation verdrängt.

Wenn Sie mit X-CUBE-AI arbeiten, nutzen Sie unbedingt die dort angebotenen Speicher- und Performance-Reports. Sie helfen, Engpässe früh zu erkennen und Alternativen zu testen (z. B. anderes Modell, Quantisierung, geringere Eingangsauflösung).

Quantisierung und Optimierung: Der Schlüssel zu „KI passt in den Mikrocontroller“

In der Praxis ist 8-Bit-Quantisierung oft der größte Hebel. Sie reduziert Modellgröße und beschleunigt Inferenz auf Cortex-M-CPUs erheblich. X-CUBE-AI unterstützt laut ST sowohl Float32 als auch 8-bit-quantisierte Formate (u. a. TensorFlow Lite und ONNX-Quantisierung) und kann je nach Zielplattform optimierte Implementierungen erzeugen: X-CUBE-AI (Features & Formate).

Wichtig ist, Quantisierung nicht als „letzten Schritt“ zu betrachten. Sie beeinflusst Training und Genauigkeit. Gute Praxis ist Quantization-Aware Training (QAT) oder zumindest eine saubere Kalibrierung für Post-Training-Quantization. Für MCU-Workloads gilt außerdem: Nicht jede Operation ist gleich gut unterstützt. Halten Sie das Modell „operator-freundlich“ (z. B. keine exotischen Layer, wenn es nicht zwingend nötig ist).

Inference-Runtimes: STM32Cube.AI vs. TensorFlow Lite for Microcontrollers

Auf STM32 begegnen Ihnen zwei häufige Laufzeitwege:

- STM32Cube.AI Runtime: ST-spezifisch optimiert, integriert in STM32Cube-Workflow und X-CUBE-AI.

- TensorFlow Lite for Microcontrollers (TFLM): allgemeine MCU-Runtime, Open-Source, breites Ökosystem.

TFLM ist als Projekt öffentlich dokumentiert und als Infrastruktur für ML auf sehr ressourcenbegrenzten Geräten beschrieben: TensorFlow Lite for Microcontrollers (Repository). Auch offizielle Dokumentation zur Modellbereitstellung auf Microcontrollern ist verfügbar: TFLM Microcontrollers Guide.

Welche Runtime besser ist, hängt vom Projektziel ab: Wenn Sie „schnell zum Ergebnis“ und tief in STM32Cube integrieren wollen, ist STs Workflow oft effizient. Wenn Sie maximale Portabilität, Community-Ökosystem oder spezielle TFLM-Beispiele benötigen, kann TFLM sinnvoll sein. In beiden Fällen gilt: Ein kleines, gut abgestimmtes Modell schlägt ein großes, schlecht angepasstes Modell.

Performance-Bausteine: CMSIS-NN als Turbo für Cortex-M

Für quantisierte neuronale Netze ist CMSIS-NN eine zentrale Optimierungsbibliothek. Sie stellt effiziente Kernel bereit, die auf Arm Cortex-M zugeschnitten sind und Speicherfootprint sowie Laufzeit verbessern können. Wenn Ihre Toolchain oder Runtime CMSIS-NN nutzt, kann das messbar Performance bringen – besonders bei Convolutions, Fully-Connected-Layern und Aktivierungsfunktionen.

Sensorik und Preprocessing: Edge AI ist nur so gut wie die Daten

Im Embedded-Bereich entscheidet die Signalqualität stärker über den Erfolg als die Modellarchitektur. Typische Fehler sind Aliasing, unpassende Abtastraten, fehlende Synchronisation oder ungünstige Fensterung. Best Practices für robuste Datenpipelines:

- Saubere Abtastrate: passend zur Signalbandbreite, mit Anti-Aliasing (analog oder digital).

- Deterministische Erfassung: Timer + DMA statt „Polling“, um Jitter zu minimieren.

- Fensterung und Feature-Berechnung: RMS, Peak, Spektralmerkmale, Zero-Crossing, Hüllkurve.

- Normalisierung: konsistente Skalierung vor der Inferenz (z. B. int8-Range).

Gerade bei Zustandsüberwachung in der Industrie ist ein hybrider Ansatz effektiv: Zuerst Signalverarbeitung und Merkmalsextraktion, dann ein kleiner Klassifikator. Das reduziert Modellkomplexität und verbessert Interpretierbarkeit.

Von der Idee zur laufenden Inferenz: Ein praxistauglicher Ablauf

Ein strukturierter Workflow hilft, typische Sackgassen zu vermeiden:

- Use Case definieren: Welche Klassen/Anomalien, welche Fehlkosten, welche Reaktionszeit?

- Daten sammeln: ausreichend repräsentativ (Betriebszustände, Temperatur, Last, Alterung).

- Baseline bauen: einfache Heuristik oder klassischer Algorithmus als Referenz.

- Modell trainieren: klein starten, Operatoren kompatibel halten, Quantisierung früh mitdenken.

- Konvertieren und integrieren: mit X-CUBE-AI/STM32Cube.AI oder TFLM.

- Benchmarking auf Zielhardware: Latenz, RAM/Flash, Worst-Case-Verhalten.

- Feldtests: Drift, neue Störquellen, reale Montagebedingungen.

Für die STM32-Welt ist STM32CubeIDE als Entwicklungsumgebung verbreitet: STM32CubeIDE. In Kombination mit X-CUBE-AI und STM32CubeMX lassen sich KI-Komponenten in einen konsistenten Build-Prozess integrieren.

Latenz, Durchsatz und Energie: Messgrößen, die Sie wirklich brauchen

Edge AI ist nur dann „embedded-tauglich“, wenn das System Echtzeitbedingungen erfüllt. Drei Größen sind zentral:

- Latenz: Zeit für eine Inferenz (inkl. Preprocessing).

- Durchsatz: Inferenz pro Sekunde bei gegebener Fenstergröße.

- Energie pro Entscheidung: relevant bei Batteriebetrieb oder großen Flotten.

Eine einfache Beziehung zwischen Fensterlänge, Schrittweite und resultierendem Inferenzrhythmus hilft bei der Planung:

Wenn Sie beispielsweise alle 50 ms eine Entscheidung treffen (Tstep = 0,05 s), benötigen Sie mindestens 20 Inferenzzyklen pro Sekunde – plus Reserve für Kommunikation und Applikationslogik. Genau hier zeigt sich der Nutzen von Benchmarking-Tools und optimierten Kerneln.

Sicherheit und Datenschutz: Edge AI als Compliance-Vorteil – mit Bedingungen

Ein häufig unterschätzter Vorteil von Edge AI ist, dass sensible Rohdaten das Gerät nicht verlassen müssen. Das hilft bei Datenschutzanforderungen und reduziert Angriffsfläche. Gleichzeitig gilt: Wenn Modelle Entscheidungen steuern (z. B. Abschalten, Alarmierung, Zugangskontrolle), wird Integrität entscheidend. Praktische Maßnahmen:

- Signierte Firmware: verhindert, dass Angreifer manipulierte Inferenzlogik einspielen.

- Gesicherte Updatepfade: kontrollierte Rollouts, Versionierung, Rollback-Strategien.

- Modellschutz: je nach Produktstrategie kann Model-Extraction ein Thema sein.

- Auditierbarkeit: Logging von Entscheidungen und Zuständen, ohne Datenschutz zu verletzen.

Edge AI ist kein Ersatz für Security Engineering, aber ein starker Baustein: Datenminimierung reduziert Risiken, sofern Updates und Integrität sauber gelöst sind.

Typische Anwendungsfälle: Wo Edge AI auf STM32 besonders sinnvoll ist

- Predictive Maintenance: Vibrations- und Stromanalyse zur Früherkennung von Lager- oder Motorproblemen.

- Anomalieerkennung im Prozess: Erkennen von Abweichungen, bevor Ausschuss entsteht.

- Audio-Events: Erkennung von Leckagen, Ventilgeräuschen, Fehlzündungen, Sicherheitsereignissen.

- Sensorfusion: IMU + Magnetometer + Drucksensoren für stabile Zustandsmodelle.

- Edge-Gateways: lokale Klassifikation, dann nur Ergebnis/Alarm in die Leitwarte.

Für sensorbasierte Anomalieerkennung ist NanoEdge AI Studio häufig ein schneller Einstieg, weil es den Weg von Daten zu einer C-Bibliothek stark vereinfacht: NanoEdge AI Studio Workflow.

Fehler, die Projekte unnötig teuer machen – und wie Sie sie vermeiden

- Zu großes Modell am Anfang: Starten Sie klein, messen Sie früh, iterieren Sie.

- Unklare Datenbasis: Ohne repräsentative Daten wird jedes Modell im Feld instabil.

- Ignorierte Speicherlast durch Stacks: Netzwerk/TLS/RTOS kosten RAM – planen Sie das ein.

- Keine Worst-Case-Messung: Jitter, Interrupt-Last und Peak-Last im Betrieb sind entscheidend.

- „Alles streamen“ statt Edge-Logik: Nachhaltiger und stabiler ist ereignisbasierte Übertragung.

Ein pragmatischer Ansatz ist, die Architektur von Anfang an so zu gestalten, dass Sie Modelle austauschen können (z. B. getrennte Module für Preprocessing, Inferenz, Postprocessing). ST nennt in X-CUBE-AI zudem Optionen, die Modell-Updates während des Produktlebenszyklus erleichtern können, indem Modellcode von Applikationscode getrennt wird: X-CUBE-AI: Modellbereitstellung und Update-Optionen.

Checkliste für den Start: Edge AI auf dem STM32 ohne Umwege

- Problem klar formulieren: Klassifikation, Regression oder Anomalie?

- Messkette stabilisieren: Abtastrate, Filter, Trigger, Zeitstempel, DMA.

- Kleines Baseline-Modell: einfache Features + kleiner Klassifikator.

- Quantisierung früh prüfen: int8-Workflow und Operator-Kompatibilität.

- Tool passend wählen: X-CUBE-AI für NN-Modelle, NanoEdge AI Studio für schnelle Sensor-Modelle.

- Benchmarking auf Zielhardware: Latenz, RAM/Flash, Energieprofil.

- Deployment absichern: reproduzierbare Builds, Updatekonzept, Logging.

Wenn Sie diese Punkte konsequent abarbeiten, wird Edge AI auf dem STM32 von einer Demonstration zu einer robusten Produktfunktion: lokal, effizient, updatefähig – und in vielen Fällen schneller und wirtschaftlicher als cloudzentrierte Ansätze.

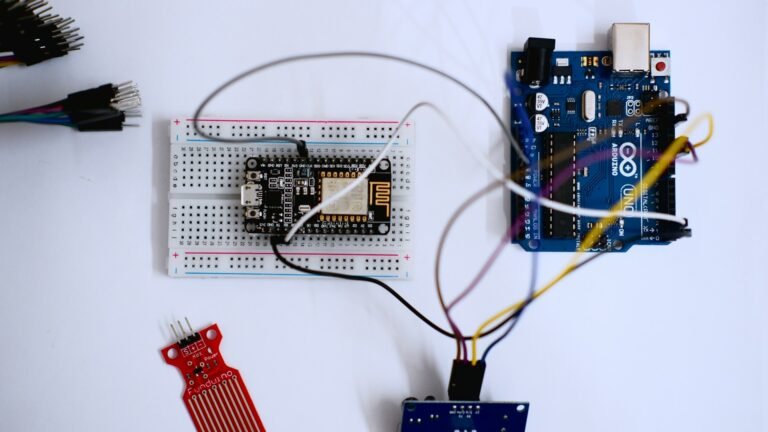

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.