Edge Computing ist längst mehr als ein Buzzword aus der Cloud-Welt: Es beschreibt die Verlagerung von Rechenleistung und Entscheidungslogik an den Rand des Netzwerks – dorthin, wo Daten entstehen. Statt Sensorwerte, Bilder oder Maschinenzustände permanent in eine entfernte Cloud zu schicken, werden sie direkt auf dem Chip, im Gateway oder auf einem lokalen Edge-Server verarbeitet. Das spart Bandbreite, reduziert Latenzzeiten und kann die Ausfallsicherheit deutlich erhöhen. Gleichzeitig wird Edge Computing immer wichtiger, weil IoT-Geräte explosionsartig zunehmen, Datenmengen wachsen und neue Anwendungen Echtzeitreaktionen verlangen – etwa in der Industrieautomation, im Smart Home, im Automotive-Bereich oder bei Wearables. Hinzu kommt ein weiterer Treiber: Datenschutz und Cyber-Security. Wer sensible Informationen bereits lokal filtert, anonymisiert oder nur als zusammengefasste Kennzahlen weiterleitet, minimiert Risiken und Kosten. In diesem Artikel erfährst du, warum die Verarbeitung auf dem Chip so stark an Bedeutung gewinnt, welche technischen Bausteine dafür entscheidend sind und wie du Edge-Architekturen sinnvoll planst – von einfachen Mikrocontroller-Projekten bis zu professionellen Edge-Plattformen.

Was Edge Computing wirklich bedeutet – und was nicht

Im Kern geht es bei Edge Computing um ein einfaches Prinzip: Daten werden so früh wie möglich verarbeitet, idealerweise dort, wo sie entstehen. Das kann ein Mikrocontroller mit Sensorik sein, ein Single-Board-Computer im Schaltschrank, ein Industrie-Gateway oder ein Edge-Server in der Filiale. Wichtig ist die Abgrenzung: Edge ist nicht zwangsläufig „ohne Cloud“. Häufig handelt es sich um eine hybride Architektur, bei der die Cloud weiterhin für langfristige Speicherung, globale Analysen, Geräteverwaltung oder KI-Training genutzt wird – während Edge für lokale Entscheidungen und Vorverarbeitung zuständig ist. Eine verständliche Einordnung bietet der Überblick zu Edge Computing bei AWS.

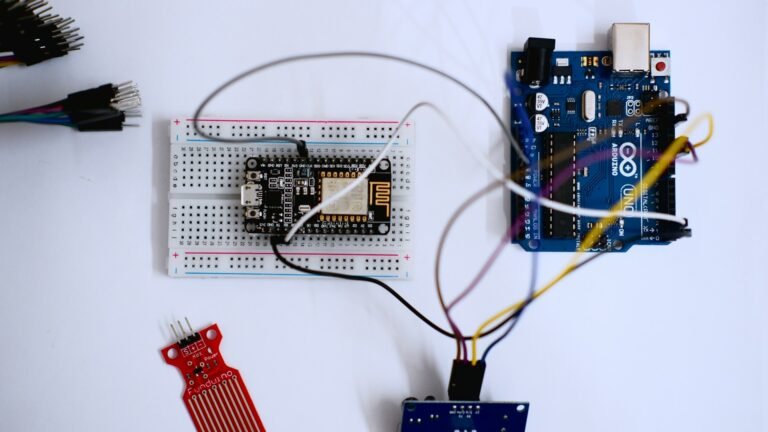

Ebenso wichtig: Edge bedeutet nicht automatisch „High-End“. Schon ein ESP32, STM32 oder RP2040 kann Edge-Aufgaben übernehmen, wenn er Messwerte plausibilisiert, Ereignisse erkennt, Motoren regelt oder Daten in sinnvolle Pakete verdichtet. Genau hier beginnt der praktische Nutzen: Rechnen kostet Strom, Datenübertragung kostet oft mehr – sowohl energetisch als auch finanziell.

Warum die Verarbeitung am Rand immer wichtiger wird

Die wachsende Bedeutung von Edge Computing lässt sich auf mehrere Trends zurückführen, die sich gegenseitig verstärken. In vielen Anwendungen ist es schlicht nicht mehr effizient, jeden Rohdatenstrom in die Cloud zu senden. Gleichzeitig werden Nutzer und Unternehmen sensibler gegenüber Datenschutz, und regulatorische Anforderungen setzen zunehmend auf Sicherheit und Minimierung von Risiken. Zudem wird in immer mehr Bereichen eine „Echtzeitfähigkeit“ erwartet, die durch entfernte Rechenzentren nicht zuverlässig garantiert werden kann.

- Datenexplosion: Kameras, Vibrationssensoren, Strommessungen oder Umweltmessungen erzeugen große Datenmengen, die als Rohdaten selten vollständig benötigt werden.

- Latenzanforderungen: Regelungstechnik, Robotik, Assistenzsysteme oder Alarmketten brauchen Reaktionen im Millisekunden- bis Sekundenbereich.

- Verfügbarkeit: Edge-Systeme können bei Internetproblemen weiterarbeiten und später synchronisieren.

- Kosten: Bandbreite, Mobilfunk, Cloud-Ingestion und Speicherung verursachen laufende Gebühren; Vorverarbeitung reduziert diese Kosten.

- Datenschutz: Lokale Filterung und Aggregation verringern die Menge sensibler Daten, die das Heim- oder Firmennetz verlassen.

Latenz: Wenn Millisekunden den Unterschied machen

Viele IoT-Projekte starten mit dem Gedanken: „Wir schicken alles in die Cloud und visualisieren es dort.“ Das funktioniert, bis Entscheidungen wirklich schnell fallen müssen. Ein Beispiel: Ein Motor muss bei Überlast sofort abschalten. Eine Tür soll bei einem unberechtigten Versuch unmittelbar verriegeln. Eine Maschine soll bei einem gefährlichen Muster in Sensordaten stoppen. Sobald du auf eine entfernte Verarbeitung setzt, addieren sich Verzögerungen: Netzwerk, Routing, Protokoll-Overhead, Cloud-Verarbeitung und Rückantwort. Das Ergebnis ist schwer vorhersehbar, besonders bei Mobilfunkverbindungen oder schwankender Netzlast.

Edge Computing löst dieses Problem, indem kritische Entscheidungen lokal getroffen werden. Die Cloud bleibt für Monitoring und Auswertung, aber die Reaktionslogik sitzt „nah“ an Sensoren und Aktoren. Für viele Szenarien ist das nicht nur schneller, sondern auch sicherer, weil Ausfälle einzelner Dienste nicht das gesamte System lahmlegen.

Bandbreite und Energie: Senden kostet oft mehr als Rechnen

Gerade bei batteriebetriebenen Geräten ist Energie die härteste Währung. Funkmodule – egal ob WLAN, LTE-M, NB-IoT oder LoRaWAN – benötigen beim Senden oft deutlich mehr Energie als ein kurzer Rechenjob auf dem Mikrocontroller. Edge Computing bedeutet in diesem Kontext: lieber lokal verdichten, nur Ereignisse übertragen und unnötige Funkaktivität vermeiden. Typische Strategien sind „Event-driven“-Übertragung, Delta-Encoding, Kompression, oder das Senden von Statistiken statt Rohdaten (Min/Max/Mittelwerte, Perzentile, Histogramme).

Ein anschauliches Beispiel ist die Zustandsüberwachung: Statt eine hochfrequente Vibrationskurve dauerhaft zu streamen, extrahiert ein Edge-Algorithmus Kennzahlen wie RMS, Peak-Faktor oder Frequenzbänder und sendet nur Anomalien. Damit wird aus einem Datenstrom ein Ereignisstrom – und genau das ist oft der Unterschied zwischen einem Prototyp und einem langfristig betreibbaren System.

Datenschutz und Compliance: Weniger Daten rausgeben, mehr Kontrolle behalten

Je mehr Daten ein Gerät nach außen überträgt, desto größer ist die Angriffsfläche – technisch und rechtlich. Edge Computing ermöglicht es, personenbezogene oder sensible Informationen bereits vor dem Verlassen des lokalen Netzes zu reduzieren. Bei Kameras kann das bedeuten: Gesichter werden lokal erkannt, aber nur als „Person erkannt: ja/nein“ gemeldet. Bei Smart-Home-Sensorik kann es heißen: Anwesenheitsmuster bleiben lokal, während die Cloud nur aggregierte Energiekennzahlen erhält.

Gerade im europäischen Kontext sind Konzepte wie Datenminimierung und Zweckbindung entscheidend. Lokale Verarbeitung unterstützt diese Prinzipien, weil du die Datenflüsse deutlich besser begrenzen und dokumentieren kannst. Ein praxisorientierter Einstieg in Datenschutzgrundsätze findet sich beim Bundesamt für Sicherheit in der Informationstechnik (BSI) sowie in allgemeinen Datenschutzinformationen der EU, etwa über Datenschutz in der EU.

Edge auf dem Mikrocontroller: Was ist realistisch?

Wenn von Edge Computing die Rede ist, denken viele sofort an leistungsstarke Industrie-Gateways oder Mini-Server. Doch Mikrocontroller sind häufig der erste und wichtigste Edge-Knoten. Realistisch sind dort vor allem Aufgaben, die wenig RAM benötigen, mit festem Timing arbeiten und robust gegenüber Ausfällen sein müssen. Dazu zählen Signalfilter, Zustandsautomaten, PID-Regelung, Protokoll-Parsing, lokale Alarme, einfache Klassifikationen oder Feature-Extraktion.

Typische Edge-Use-Cases auf dem Chip

- Vorverarbeitung: Glätten, Median-Filter, Kalibrierung, Einheitenumrechnung, Plausibilitätsprüfungen.

- Ereigniserkennung: Schwellenwerte, Muster (z. B. „Stromspitze“), Zustandswechsel (Tür offen/zu).

- Lokale Steuerung: Motorregelung, Sicherheitsschaltungen, zeitkritische Aktorik.

- Feature-Extraktion: Kennzahlen aus Rohdaten, z. B. statistische Merkmale oder Frequenzanteile.

- Offline-Fähigkeit: Puffern, Retry-Logik, „Store and forward“ bei Netzausfall.

Edge-KI und TinyML: Intelligenz wird kleiner – und näher am Sensor

Ein wesentlicher Treiber für Edge Computing ist die Miniaturisierung von Machine-Learning-Modellen. Mit TinyML lassen sich Modelle so komprimieren, dass sie auf Mikrocontrollern laufen – oft mit quantisierten Gewichten und optimierten Inferenzbibliotheken. Der Vorteil ist erheblich: Klassifikation oder Anomalieerkennung erfolgen lokal, ohne Rohdaten in die Cloud zu senden. Das ist besonders attraktiv bei Audio, Vibrationen, Bildsensoren oder komplexen Umweltsignalen.

Natürlich ist Edge-KI nicht für jedes Projekt sinnvoll. Modelle brauchen Pflege, Tests und klare Datenqualität. Aber für viele Anwendungen ist ein kleines Modell am Rand effizienter als ein großes Modell in der Cloud, weil es dort sofort reagieren kann und nur relevante Ergebnisse überträgt. Grundlagen und Praxisressourcen bietet beispielsweise TensorFlow Lite for Microcontrollers.

Architektur: Edge, Fog und Cloud sinnvoll kombinieren

In der Praxis besteht moderne IoT-Architektur häufig aus mehreren Ebenen. Der Mikrocontroller sammelt Daten und trifft erste Entscheidungen. Ein Gateway übernimmt Protokollübersetzung, Gerätemanagement und lokale Datenhaltung. Die Cloud dient als zentrale Plattform für Flottenverwaltung, Dashboards, Langzeittrends und überregionale Auswertungen. Manche Konzepte sprechen bei der Zwischenschicht aus Gateways und lokalen Knoten auch von „Fog Computing“. Entscheidend ist weniger das Label, sondern die klare Zuordnung: Welche Entscheidungen müssen lokal passieren, welche können zentral erfolgen?

- On-Device Edge: unmittelbare Sensor-/Aktor-Logik, Echtzeit, Low-Power, robust.

- Gateway Edge: lokale APIs, Protokoll-Bridge (z. B. Modbus <-> MQTT), Zwischenspeicher, Updates.

- Cloud: Analyse über lange Zeiträume, Geräteverwaltung, globale Regeln, KI-Training, Reporting.

Netzwerkrealität: Warum „offline first“ zunehmend ein Qualitätsmerkmal ist

Viele Systeme werden heute in Umgebungen betrieben, in denen Netzwerk nicht garantiert ist: Kellerräume, Baustellen, ländliche Gebiete, mobile Installationen oder abgeschottete Produktionsnetze. Ein Edge-System, das nur mit dauerhafter Cloud-Verbindung funktioniert, ist dort fehleranfällig. „Offline first“ bedeutet nicht, dass es keine Cloud gibt, sondern dass das Gerät bei Verbindungsproblemen sinnvoll weiterarbeitet: Es protokolliert lokal, entscheidet lokal und synchronisiert später.

Ein weiterer Vorteil: Du reduzierst den Druck, jede kleine Messwertänderung sofort zu übertragen. Stattdessen definierst du sinnvolle Synchronisationspunkte und Prioritäten. Das führt meist zu stabileren Geräten, weniger Supportfällen und besserer Nutzererfahrung.

Security by Design: Edge ist Chance und Herausforderung zugleich

Edge Computing kann Sicherheit verbessern, weil weniger Daten transportiert werden und lokale Entscheidungen nicht vom Internet abhängen. Gleichzeitig entstehen neue Anforderungen: Wenn mehr Logik auf dem Gerät läuft, wird das Gerät selbst attraktiver für Angriffe. Deshalb gilt 2026 mehr denn je: sichere Updatefähigkeit, signierte Firmware, minimierte Angriffsfläche und sauberer Umgang mit Geheimnissen sind Pflicht – egal ob Hobbyprojekt oder Produkt.

Für eine praxisnahe Orientierung helfen anerkannte Leitlinien wie ETSI EN 303 645 (Consumer IoT Security) sowie Checklisten aus der Security-Community, etwa das OWASP IoT Project. Auch wenn du nicht alles sofort umsetzt: Eine klare Baseline (keine Default-Passwörter, keine offenen Debug-Ports, TLS wo möglich, Updates planbar) hebt die Qualität spürbar.

Tooling und Plattformen: Was du für Edge-Projekte wirklich brauchst

Edge Computing ist nicht nur eine Architekturfrage, sondern auch ein Tooling-Thema. Du brauchst eine stabile Build- und Release-Pipeline, Logging, Monitoring und idealerweise reproduzierbare Builds. Auf Mikrocontroller-Ebene helfen Debugger, serielles Logging, Ringbuffer und Watchdogs. Auf Gateway-Ebene kommen Container, Message-Broker und lokale Datenbanken hinzu. Für viele Projekte ist MQTT weiterhin ein bewährter Standard, weil es leichtgewichtig und gut integrierbar ist; Grundlagen dazu findest du beim offiziellen MQTT-Projekt.

Praktische Bausteine, die Edge-Projekte beschleunigen

- Message-Broker lokal: MQTT-Broker im Heimnetz oder im Gateway, um Geräte zu entkoppeln.

- Lokale Persistenz: kleine Datenbank oder Dateispeicher für Offline-Puffer und Debugging.

- Observability: Metriken (z. B. Fehlerzähler), Logs, Health-Checks, Diagnosemodus.

- OTA-Update-Prozess: klarer Versionspfad, Rollback, Signaturprüfung.

Praxisbeispiele: Wo Edge Computing heute den größten Nutzen bringt

Der größte Effekt entsteht dort, wo Latenz, Datenvolumen oder Verfügbarkeit kritisch sind. Genau deshalb sieht man Edge Computing besonders häufig in Industrie, Mobilität und Smart Home.

- Industrie & Predictive Maintenance: lokale Anomalieerkennung an Maschinen, nur relevante Events in die Cloud.

- Smart Home: lokale Automationen laufen auch ohne Internet; Cloud nur für Fernzugriff oder Backups.

- Medizin- und Wearables: Vorverarbeitung reduziert Datenmengen und schützt sensible Informationen.

- Retail/Filialen: lokale Edge-Server für Kameras, Inventur oder Kassensysteme, zentrale Auswertung später.

- Fahrzeuge: Entscheidungen müssen lokal fallen; Cloud dient eher für Diagnosen und Flottenanalyse.

Wie du entscheidest, ob Edge oder Cloud die bessere Wahl ist

Edge Computing ist nicht automatisch „besser“. Es verschiebt Komplexität: weniger Cloud-Abhängigkeit, aber mehr Verantwortung auf dem Gerät. Eine sinnvolle Faustregel lautet: Alles, was zeitkritisch, sicherheitsrelevant oder datenschutzsensibel ist, sollte so nah wie möglich an der Quelle verarbeitet werden. Alles, was langfristige Trends, globale Optimierung oder Flottenmanagement betrifft, kann zentral erfolgen.

- Edge bevorzugen, wenn: Echtzeit nötig ist, Datenvolumen hoch ist, Offline-Fähigkeit wichtig ist, Datenschutz kritisch ist.

- Cloud bevorzugen, wenn: globale Modelle trainiert werden, große historische Datenanalysen nötig sind, zentrale Verwaltung dominiert.

- Hybrid wählen, wenn: lokale Entscheidungen und zentrale Optimierung zusammenarbeiten müssen.

Ausblick: Warum „mehr Chip“ nicht nur Leistung, sondern Verantwortung bedeutet

Dass Verarbeitung auf dem Chip immer wichtiger wird, ist keine Mode, sondern eine Folge realer Anforderungen: mehr Daten, mehr Geräte, mehr Erwartungen an Echtzeit und Sicherheit. Gleichzeitig werden Mikrocontroller leistungsfähiger, energieeffizienter und besser in der Lage, komplexe Logik zu tragen – von Protokoll-Stacks über sichere Bootprozesse bis hin zu TinyML-Inferenz. Wer heute Edge Computing ernst nimmt, baut Systeme, die schneller reagieren, weniger abhängig sind und besser skalieren. Entscheidend ist, Edge nicht als einzelne Technik zu betrachten, sondern als Designprinzip: Daten intelligent behandeln, Entscheidungen dort treffen, wo sie am meisten Sinn ergeben, und die Cloud als Ergänzung nutzen – nicht als Krücke.

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.