Das Thema KI auf dem Nano klingt zunächst wie ein Widerspruch: künstliche Intelligenz, aber auf einem Mikrocontroller mit sehr begrenztem Speicher, niedriger Taktfrequenz und ohne Betriebssystem. Genau hier beginnt jedoch der Reiz von TinyML. Statt große Modelle in der Cloud auszuführen, werden kleine, optimierte Modelle direkt auf dem Gerät eingesetzt. Für Einsteiger bedeutet das: weniger Latenz, oft geringerer Energieverbrauch, mehr Datenschutz und ein klarer Fokus auf konkrete Aufgaben wie Mustererkennung, einfache Klassifikation oder Anomalieerkennung. Der Arduino Nano ist dafür ein hervorragendes Lernwerkzeug, weil man bei jedem Schritt versteht, wie Daten entstehen, wie Modelle vereinfacht werden und wie Inferenz im Embedded-Kontext wirklich funktioniert. In diesem Leitfaden lernst du praxisnah, was auf dem Nano realistisch ist, welche Workflows funktionieren, wie du typische Fehler vermeidest und wie du dein erstes TinyML-Projekt strukturiert von der Idee bis zur stabilen Laufzeit aufbaust.

Was TinyML bedeutet und warum es für Mikrocontroller relevant ist

TinyML steht für Machine Learning auf ressourcenbeschränkter Hardware. Während klassische KI-Modelle häufig auf Servern oder leistungsstarken Edge-Geräten laufen, setzt TinyML auf kleine neuronale Netze oder alternative ML-Verfahren, die in wenigen Kilobyte bis wenigen Hundert Kilobyte Speicher passen. Das Ziel ist nicht „allgemeine Intelligenz“, sondern robuste Lösungen für klar definierte Aufgaben.

In der Praxis geht es oft um:

- Klassifikation von Sensordaten, z. B. Bewegungstypen oder Vibrationsmuster

- Einfache Sprach- oder Geräuscherkennung mit stark reduzierten Modellen

- Anomalieerkennung, z. B. ungewöhnliches Maschinenverhalten

- Regelbasierte KI-Hybridansätze, bei denen ML nur einen Teil der Entscheidung übernimmt

Für den Nano ist TinyML besonders spannend, weil du direkt am Signal arbeitest. Du lernst, wie Datenerhebung, Feature Engineering, Quantisierung und Laufzeitoptimierung zusammenhängen. Das hilft nicht nur bei KI-Projekten, sondern verbessert auch dein gesamtes Embedded-Verständnis.

Hardware-Realität beim Arduino Nano: Grenzen und Chancen

Der klassische Arduino Nano auf Basis des ATmega328P ist stark limitiert. Das ist kein Nachteil, sondern ein didaktischer Vorteil: Du erkennst sofort, warum Modellgröße, Eingabedatenformat und Inferenzfrequenz entscheidend sind. Du kannst nicht einfach ein beliebiges Netz „deployen“, sondern musst systematisch reduzieren.

- Begrenzter Flash-Speicher erzwingt kleine Modelle und schlanken Code

- Sehr knappes RAM verlangt sorgfältige Buffer-Planung

- Niedrige Rechenleistung setzt kurze Eingabevektoren und effiziente Operatoren voraus

Wenn du auf einem Nano 33 BLE Sense oder ähnlichen Boards arbeitest, sind die Möglichkeiten deutlich größer. Für den TinyML-Einstieg gilt dennoch: beginne mit kleinen Klassifikationsproblemen, wenigen Klassen und kurzen Datenfenstern. Das ist die schnellste Route zu belastbaren Ergebnissen.

Wichtige Faustregel für Einsteiger

Je kleiner dein Modell und je klarer dein Problem, desto höher die Chance auf stabile Inferenz im Feldbetrieb. Zu große Ambitionen am Anfang führen fast immer zu Speicherfehlern, instabilen Vorhersagen oder unbrauchbaren Latenzen.

Geeignete Anwendungsfälle für den TinyML-Einstieg auf dem Nano

Nicht jede KI-Idee passt auf kleine Controller. Besonders geeignet sind Aufgaben mit niedriger Eingabedimension und klar trennbaren Mustern.

- Gestenerkennung mit IMU: kurze Bewegungsmuster wie Klopfen, Neigen, Schütteln

- Vibrationsklassifikation: „normal“ vs. „auffällig“ bei Motoren oder Lüftern

- Akustische Ereignisse: begrenztes Set einfacher Ereignisse, z. B. Klatschen

- Zustandsmonitoring: Sensorfusion aus Temperatur, Feuchte, Beschleunigung

Weniger geeignet sind große Sprachmodelle, komplexe Bildverarbeitung in hoher Auflösung oder Aufgaben mit vielen Klassen und stark variierenden Umgebungsbedingungen ohne umfangreiche Datenerhebung.

Der komplette TinyML-Workflow: Von Rohdaten bis Inferenz auf dem Nano

Ein erfolgreicher TinyML-Prozess besteht aus mehreren klaren Schritten. Wer diese Reihenfolge einhält, spart Zeit und erhöht die Modellqualität deutlich.

Datenerhebung am realen Einsatzort

Sammle Daten dort, wo das Modell später laufen soll. Laborbedingungen führen häufig zu schlechter Generalisierung. Achte auf verschiedene Winkel, Geschwindigkeiten, Personen, Untergründe und Störquellen. Beschrifte Daten sauber und konsistent.

Datenbereinigung und Segmentierung

Teile kontinuierliche Sensordaten in Fenster auf, zum Beispiel 1 bis 2 Sekunden. Entferne fehlerhafte Segmente, synchronisiere Kanäle und prüfe Klassenbalance. Unsaubere Labels sind einer der häufigsten Gründe für schlechte Modelle.

Feature Engineering oder End-to-End

Für sehr kleine Controller lohnt sich Feature Engineering oft mehr als End-to-End-Netze. Statt Rohsignal kannst du z. B. Mittelwert, Standardabweichung, Energie oder Frequenzanteile je Fenster nutzen. Das reduziert Rechenlast und Modellgröße.

Training und Validierung

Trainiere mit sauber getrennten Datensätzen für Training, Validierung und Test. Nutze Metriken wie Genauigkeit, F1-Score und Konfusionsmatrix. Für reale Anwendungen sind False Positives und False Negatives wichtiger als reine Accuracy.

Quantisierung und Export

Konvertiere das Modell in ein MCU-taugliches Format, typischerweise int8-quantisiert. Dadurch sinken Speicherbedarf und Rechenzeit deutlich. Anschließend wird das Modell als C-Array ins Projekt eingebunden.

Deployment und Laufzeittest

Teste nicht nur auf dem Entwicklungsrechner, sondern auf dem echten Nano unter realen Bedingungen. Miss Inferenzzeit, RAM-Spitzenlast und Verhalten bei Rauschen. Erst danach lohnt sich die Feinoptimierung.

Modellgröße, Speicherbedarf und Latenz richtig einschätzen

Beim Einstieg in KI auf dem Nano ist die wichtigste Kompetenz das Abschätzen von Ressourcen. Du brauchst ein Gefühl dafür, wie sich Eingabegröße, Layer-Struktur und Quantisierung auf Laufzeit und Speicher auswirken.

Eine vereinfachte Abschätzung für den Speicherbedarf quantisierter Gewichte lautet:

mit

Für die Inferenzfrequenz ist die Zykluszeit entscheidend. Wenn ein Inferenzdurchlauf

Bei

Typische Modellarchitekturen für kleine Controller

Nicht jede Architektur passt auf den Nano. Für den Einstieg haben sich kompakte, robuste Strukturen bewährt:

- Kleine MLPs: gut für tabellarische Features, schnell und speichersparend

- 1D-CNNs: sinnvoll bei Zeitreihen, wenn lokale Muster wichtig sind

- Tiny-DS-CNN: für bestimmte Audioaufgaben, aber nur bei sehr strikter Optimierung

- Nicht-neuronale Modelle: z. B. Entscheidungsbäume als extrem leichte Alternative

Für viele Nano-Projekte ist ein kleines MLP mit sauber gewählten Features der schnellste Weg zu guter Praxisleistung.

Datenqualität schlägt Modellkomplexität

Ein häufiges Missverständnis ist, dass bessere Ergebnisse automatisch größere Netze erfordern. In der Embedded-Praxis gilt oft das Gegenteil: bessere Daten schlagen größere Modelle. Wenn die Klassen sauber erfasst, gut ausbalanciert und realitätsnah sind, kann ein kleines Modell erstaunlich robust arbeiten.

- Erfasse pro Klasse ausreichend Variationen

- Vermeide „leere“ Klassen mit zu wenigen Beispielen

- Nutze identische Samplingraten in Training und Laufzeit

- Dokumentiere Sensorposition und Kalibrierung

Diese Disziplin ist zentral für E-E-A-T in technischen Inhalten: nachvollziehbare Methodik ist wichtiger als spektakuläre Modellnamen.

Tooling für TinyML-Projekte mit Nano

Ein stabiler Werkzeug-Stack beschleunigt Entwicklung und Fehlersuche. Für viele Maker ist eine Kombination aus Python-Workflow für Training und Arduino-IDE/PlatformIO für Deployment praktikabel.

- Grundlagen und Beispiele zu TinyML: TensorFlow Lite for Microcontrollers

- Praxisnahe TinyML-Workflows: Edge Impulse

- Arduino Machine Learning Doku: Arduino Tutorials

- Allgemeiner Embedded-ML-Kontext: AI on Arm

Wenn du strukturiert arbeitest, reichen oft wenige Tools: Datenerhebungsskript, Trainingsnotebook, Konverter, Firmwareprojekt mit reproduzierbarer Build-Konfiguration.

Praxisbeispiel: Gestenerkennung mit 3 Klassen

Ein didaktisch ideales Einstiegsprojekt ist die Erkennung von drei Gesten mit einem Beschleunigungssensor: „Ruhe“, „Neigen“, „Schütteln“.

Projektstruktur

- Datensammlung pro Klasse mit mehreren Personen und Geschwindigkeiten

- Fensterbildung, z. B. 1 Sekunde bei fixer Samplingrate

- Feature-Set: Mittelwert, Varianz, Signalenergie je Achse

- Kleines MLP mit quantisierter Inferenz

- Ausgabe über LED oder seriellen Monitor

Warum dieses Projekt so gut funktioniert

Das Problem ist überschaubar, die Daten lassen sich schnell erfassen, und die Unterschiede zwischen den Klassen sind klar genug, um auch mit kleinen Modellen gute Ergebnisse zu erzielen. Gleichzeitig lernst du alle zentralen Schritte von TinyML, ohne an übergroßer Komplexität zu scheitern.

Fehlerquellen beim TinyML-Einstieg und wie du sie vermeidest

Die meisten Probleme entstehen nicht beim Training, sondern beim Übergang zur Embedded-Laufzeit.

- Mismatch der Vorverarbeitung: Training nutzt andere Normalisierung als Firmware

- Falsche Samplingrate: Modell wurde mit 100 Hz trainiert, Gerät liefert 50 Hz

- Speicherüberlauf: Zu große Buffer oder Debug-Ausgaben im RAM

- Klassenverschiebung: Reale Umgebung unterscheidet sich stark vom Trainingssetup

- Overfitting: Hohe Trainingsgenauigkeit, schlechte Felddatenleistung

Abhilfe schafft ein fester Deployment-Check: gleiche Vorverarbeitung, gleiche Fensterlänge, gleiche Skalierung, reproduzierbare Testdaten und Logging der Rohwerte auf dem Gerät.

Optimierungsstrategien für bessere Laufzeit auf kleinen Controllern

Wenn das Modell knapp nicht passt oder zu langsam ist, helfen oft kleine, systematische Schritte:

- Weniger Features oder kürzere Fensterlänge

- Reduzierte Hidden-Layer-Breite statt zusätzlicher Layer

- Konsequente int8-Quantisierung

- Fixed-Point-nahe Vorverarbeitung

- Sparsames Logging im Produktionsmodus

Ein guter Ansatz ist iteratives Profiling: nach jeder Änderung Speicherbedarf, Inferenzzeit und Fehlerrate messen. So vermeidest du Optimierungen, die zwar schneller sind, aber die Erkennungsqualität zerstören.

Datenschutz, Offline-Fähigkeit und Energieeffizienz als Praxisvorteile

Ein zentraler Pluspunkt von TinyML auf dem Nano ist die lokale Verarbeitung. Daten müssen nicht zwingend in eine Cloud übertragen werden. Das reduziert Datenschutzrisiken und verbessert Reaktionszeiten. Für mobile oder batteriebetriebene Anwendungen ist außerdem relevant, dass Controller-Modelle mit niedriger Taktrate und Schlafzyklen effizient betrieben werden können.

Gerade in sensiblen Bereichen wie Schule, Gesundheitsnähe oder privatem Wohnraum kann lokale Inferenz ein entscheidendes Architekturargument sein.

Für wen eignet sich welcher Einstiegspfad?

Je nach Erfahrungsstand lohnt sich ein anderer Fokus:

Einsteiger

- Starte mit 2 bis 3 Klassen und klaren Sensormustern

- Nutze einfache Features statt Rohsignal-End-to-End

- Arbeite mit festen Datensammelprotokollen

Mittelstufe

- Vergleiche mehrere Modelltypen systematisch

- Führe Cross-Validation und Fehleranalyse ein

- Baue robuste Runtime-Guards gegen Ausreißer

Profis

- Automatisiere Training-zu-Firmware-Pipelines

- Nutze Hardwareprofiling und Memory-Budgets pro Modul

- Plane Versionierung von Daten, Modell und Firmware als Einheit

Redaktionelle SEO-Perspektive: Relevante Begriffe natürlich integrieren

Für ein suchmaschinenfreundliches Thema wie TinyML-Einstieg für den kleinen Controller funktionieren semantisch verwandte Begriffe besonders gut, wenn sie kontextuell eingebettet sind: Edge AI, Embedded ML, Inferenz auf Mikrocontroller, Quantisierung, Modellkompression, Sensordatenklassifikation, Echtzeit-Entscheidung und On-Device-KI. Wichtig ist, dass diese Begriffe nicht künstlich gehäuft, sondern aus dem technischen Zusammenhang heraus verwendet werden.

Guter SEO-Content entsteht hier durch klare Struktur, nachvollziehbare Schritte, belastbare Praxisbeispiele und saubere Terminologie. Genau das erhöht sowohl Nutzwert als auch Sichtbarkeit.

Checkliste für dein erstes belastbares Nano-TinyML-Projekt

- Problem klar definiert und auf wenige Klassen begrenzt

- Daten am realen Einsatzort erfasst und sauber gelabelt

- Vorverarbeitung dokumentiert und identisch in Firmware umgesetzt

- Modell quantisiert und Speicherbedarf gemessen

- Inferenzzeit auf echter Hardware geprüft

- Fehlerfälle mit realen Stördaten getestet

- Projektartefakte versioniert: Datensatz, Training, Modell, Firmware

Wer diesen Ablauf konsequent umsetzt, erlebt schnell, dass KI auf dem Nano keine Marketingidee ist, sondern ein realistischer, technisch sauberer Einstieg in praktische Edge-Intelligenz. TinyML zwingt zu klaren Entscheidungen, fördert sauberes Engineering und liefert bereits mit kleinen Modellen messbaren Nutzen im Alltag von Maker-, Schul- und Prototyping-Projekten.

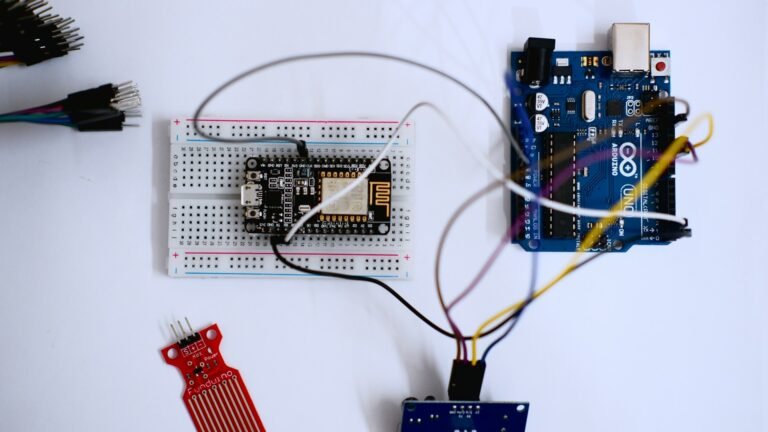

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.