Künstliche Intelligenz: Einstieg in TensorFlow Lite auf dem Raspberry Pi ist eine der besten Möglichkeiten, KI praktisch zu erleben, ohne gleich einen teuren Server oder eine leistungsstarke GPU zu benötigen. TensorFlow Lite (TFLite) ist darauf ausgelegt, Modelle effizient auf „Edge“-Geräten auszuführen – also direkt dort, wo die Daten entstehen. Genau das passt perfekt zum Raspberry Pi: kompakt, stromsparend, mit Kamera- und Sensoranbindung und ideal für Projekte wie Objekterkennung, Personenerkennung, Audio-Trigger („Hotword“), Qualitätskontrolle im Hobbybereich oder smarte Automatisierungen. Damit der Einstieg gelingt, sollten Sie jedoch zwei Dinge von Anfang an richtig einordnen: Erstens unterscheidet sich Inference (Modell ausführen) deutlich von Training (Modell trainieren). Auf dem Pi ist Inference das Ziel, Training passiert meist auf dem PC oder in der Cloud. Zweitens hängt die Performance stark davon ab, welches Modell Sie wählen, ob es quantisiert ist (z. B. INT8) und ob Sie Hardwarebeschleunigung nutzen. Diese Anleitung führt Sie strukturiert durch die Grundlagen, die Installation auf Raspberry Pi OS (inklusive Bookworm-Besonderheiten), den Umgang mit .tflite-Modellen, erste Inference-Schritte in Python sowie die wichtigsten Stellschrauben, um Latenz und Stabilität im Alltag deutlich zu verbessern.

Was ist TensorFlow Lite und warum ist es für den Raspberry Pi geeignet?

TensorFlow Lite ist eine Laufzeitumgebung und ein Ökosystem rund um kompakte Modelle, die auf mobilen und eingebetteten Systemen effizient laufen sollen. Im Vergleich zu „vollem“ TensorFlow ist TFLite deutlich schlanker und fokussiert sich auf das schnelle Ausführen bereits trainierter Modelle. Typische Vorteile im Raspberry-Pi-Kontext:

- Geringere Systemlast: Weniger Speicherbedarf und meist geringere CPU-Auslastung als komplette ML-Frameworks.

- Edge-taugliche Modelle: Viele vortrainierte Modelle existieren bereits als .tflite-Variante.

- Beschleunigung möglich: Je nach Setup können Delegates oder Coprozessoren die Inference deutlich beschleunigen.

- Gute Python-Integration: Der zentrale Einstiegspunkt ist der Interpreter, der .tflite-Modelle ausführt.

Als technische Referenz zum Python-Interpreter eignet sich die offizielle API-Dokumentation: tf.lite.Interpreter (TensorFlow API).

Hardware und Erwartungen: Was ist realistisch auf dem Pi?

Mit einem Raspberry Pi lassen sich viele KI-Projekte flüssig umsetzen, wenn Sie die Rahmenbedingungen berücksichtigen. Die Performance hängt maßgeblich von CPU, RAM, Datenträger und Modelltyp ab. Für Einsteiger gilt: Je kleiner und besser optimiert das Modell, desto angenehmer das Ergebnis.

- Raspberry Pi 5: Sehr empfehlenswert für Computer-Vision-Projekte (Kamera + Objekterkennung) und spürbar mehr Reserven.

- Raspberry Pi 4: Für viele TFLite-Modelle ausreichend, insbesondere bei moderaten Auflösungen und quantisierten Modellen.

- SSD statt microSD: Für stabile Systeme (Logs, Modelle, Updates) ist eine SSD häufig zuverlässiger.

- Kühlung: Bei längeren Inference-Schleifen kann thermische Drosselung auftreten; Kühlkörper oder Lüfter erhöhen Stabilität.

Realistische Zielsetzung: Eine Objekterkennung in 640×480 mit einem effizienten Modell kann praktikabel sein, während große, schwere Modelle oder hohe Auflösungen schnell an Grenzen stoßen.

Raspberry Pi OS (Bookworm) und Python: Virtuelle Umgebungen richtig nutzen

Seit Raspberry Pi OS Bookworm ist der Umgang mit Python-Paketen strikter: System-Python soll nicht mehr „wild“ mit pip überschrieben werden. Für KI-Projekte ist das sogar ein Vorteil, weil virtuelle Umgebungen (venv) reproduzierbare Setups fördern. Das offizielle Raspberry-Pi-Handbuch beschreibt diesen Hintergrund und empfiehlt den Einsatz von venv, statt Pakete direkt ins System-Python zu installieren: Hinweise zu Python und Bookworm in der Raspberry-Pi-Dokumentation.

- Empfehlung: Legen Sie für jedes Projekt eine venv an (z. B. „tflite-vision“).

- Vorteil: Saubere Abhängigkeiten, einfache Updates, weniger Konflikte.

- Praxistipp: Dokumentieren Sie Ihre Pakete (requirements.txt), damit das Setup auf einem zweiten Pi identisch wird.

Installation: TensorFlow Lite Runtime statt „volles“ TensorFlow

Für reine Inference ist tflite-runtime oft die pragmatischste Wahl: deutlich kleiner als das komplette TensorFlow-Paket und fokussiert auf den Interpreter. Genau dieses Paket ist für viele Raspberry-Pi-Projekte ausreichend, weil Sie damit .tflite-Modelle laden und ausführen können, ohne ein schwergewichtiges Framework zu installieren. Als Referenz eignet sich die Paketbeschreibung auf PyPI: tflite-runtime auf PyPI.

- Wann tflite-runtime genügt: Sie führen fertige .tflite-Modelle aus und konvertieren nicht auf dem Pi.

- Wann volles TensorFlow sinnvoll ist: Sie wollen auf dem Pi konvertieren, trainieren oder komplexe TF-Workflows nutzen (oft nicht nötig).

- Abhängigkeiten: Zusätzlich häufig benötigt: numpy, pillow oder opencv-python (je nach Projekt).

Für Einsteiger ist der Weg meist: Modell am PC auswählen/konvertieren → .tflite auf den Pi kopieren → Inference mit tflite-runtime.

Modelle verstehen: .tflite, Quantisierung und warum INT8 so wichtig ist

Ein .tflite-Modell ist bereits für Inference optimiert. Dennoch gibt es große Unterschiede in Laufzeit und Speicherbedarf. Der zentrale Performance-Hebel ist häufig die Quantisierung. Vereinfacht gesagt werden Gewichte und Aktivierungen von „float“ in effizientere Formate überführt, z. B. INT8. Das reduziert Rechenaufwand und kann auf Edge-Geräten den Unterschied zwischen „ruckelig“ und „flüssig“ ausmachen.

- Float32: Höhere Präzision, oft langsamer und speicherintensiver.

- Float16: Kompromiss, kann Speicher sparen.

- INT8 (quantisiert): Häufig deutlich schneller und edge-tauglich; ideal für viele Pi-Projekte.

Wichtig: Quantisierung ist nicht immer „gratis“. Bei manchen Aufgaben kann die Genauigkeit leicht sinken. In der Praxis ist das für viele Maker-Projekte akzeptabel, wenn Stabilität und Geschwindigkeit deutlich steigen.

Erster Inference-Durchlauf: Wie der TFLite-Interpreter grundsätzlich arbeitet

Der Ablauf ist in fast allen Projekten ähnlich, unabhängig davon, ob Sie Bilder, Audio oder Sensordaten verarbeiten:

- Modell laden: Interpreter initialisieren und Tensoren allokieren.

- Input vorbereiten: Daten in die erwartete Form bringen (Größe, Datentyp, Normalisierung).

- Invoke ausführen: Inference starten.

- Output interpretieren: Ergebnisse dekodieren (Labels, Scores, Bounding Boxes, Klassen).

Die offiziellen Interpreter-Beispiele zeigen dieses Muster sehr klar: TFLite Python Interpreter (Google AI Edge).

Bildverarbeitung mit Kamera: Praktischer Einstieg über Picamera2

Viele KI-Projekte auf dem Pi beginnen mit Computer Vision: eine Kamera liefert Frames, das Modell erkennt Objekte oder Klassen, und Sie reagieren darauf. Auf Raspberry Pi OS ist Picamera2 die moderne, libcamera-basierte Lösung. Für praxisnahe Nutzung sind zwei Punkte entscheidend: stabile Kameraeinstellungen (Belichtung/Weißabgleich) und effiziente Bildpipeline (nicht unnötig hochauflösend verarbeiten).

- Stabilität: Fixieren Sie – wenn möglich – Parameter, damit Ihre Inference nicht durch flackernde Belichtung schwankt.

- Auflösung: Nutzen Sie nur so viele Pixel wie nötig (z. B. 640×480 oder 320×320 je nach Modell).

- Farbraum: Prüfen Sie, ob das Modell RGB erwartet oder z. B. BGR (typisch bei OpenCV).

Als Referenz für Picamera2 eignet sich das offizielle Repository: Picamera2 (GitHub). Ergänzend ist die Raspberry-Pi-Kamera-Dokumentation hilfreich: Camera Python Doku (Raspberry Pi).

Performance-Grundlagen: Latenz messen statt „gefühlt optimieren“

Gerade am Anfang wird oft an der falschen Stelle optimiert. Deshalb lohnt es sich, die Inference-Zeit zu messen und den Gesamtdurchlauf zu unterscheiden: Kamera-Frame holen, Preprocessing, Inference, Postprocessing, Ausgabe. Häufig ist nicht die Inference das Hauptproblem, sondern das Preprocessing (Resize/Normalize) oder das Zeichnen von Overlays.

- Warm-up: Messen Sie nicht nur den ersten Lauf; der ist oft langsamer.

- Durchschnitt und Perzentile: Neben dem Mittelwert sind Ausreißer (Lag-Spikes) relevant.

- FPS vs. Latenz: Für Live-Anwendungen zählt beides: stabile Bildrate und geringe Verzögerung.

Ein hilfreicher Ansatz ist, die Zeit pro Schritt separat zu erfassen und nur dort zu optimieren, wo tatsächlich die meiste Zeit verloren geht.

Konkrete Stellschrauben für bessere TFLite-Performance auf dem Raspberry Pi

Wenn das Grundsetup läuft, bringen diese Maßnahmen häufig den größten Effekt, ohne dass Sie Ihr Projekt komplett umbauen müssen:

- Modellwahl: Nutzen Sie „mobile“ Modelle (z. B. MobileNet-Varianten) statt großer Architekturen.

- Quantisierte Modelle bevorzugen: INT8 kann auf Edge-Geräten deutlich schneller laufen.

- Input-Size reduzieren: Ein Modell mit 224×224 oder 320×320 ist oft ausreichend und viel schneller als 640×640.

- Batching vermeiden: Auf dem Pi ist Batch=1 für Live-Inference meist sinnvoller.

- Threads sinnvoll setzen: Mehr Threads sind nicht immer besser; testen Sie 1–4 Threads systematisch.

- Preprocessing optimieren: Resize und Normalisierung effizient umsetzen; unnötige Konvertierungen vermeiden.

Für praxisorientierte Objekt-Erkennungs-Setups auf Pi 4/5 existieren detaillierte Schritt-für-Schritt-Guides, die auch Performance-Aspekte adressieren, z. B.: Adafruit Guide: TensorFlow Lite auf Raspberry Pi 4/5.

Delegates und Beschleunigung: CPU, Edge TPU und wann es sich lohnt

Ohne zusätzliche Hardware läuft TFLite standardmäßig auf der CPU. Für viele Anwendungen reicht das – besonders bei leichten Modellen. Wenn Sie jedoch höhere FPS oder niedrigere Latenzen benötigen, kann ein Coprozessor sinnvoll sein. Ein bekanntes Beispiel ist die Google Coral Edge TPU, die für bestimmte quantisierte Modelle enorme Beschleunigung bringen kann. Wichtig: Nicht jedes Modell läuft „einfach so“ auf der Edge TPU; häufig sind spezielle Kompilierung und INT8-Modelle nötig.

- Wann CPU reicht: Statusklassifikation, sporadische Erkennung, wenige Frames pro Sekunde, kleine Modelle.

- Wann Beschleunigung sinnvoll ist: Echtzeit-Objekterkennung, mehrere Streams, komplexere Modelle bei stabiler Bildrate.

- Hürde: Kompatibilität (Modelle, Operatoren), zusätzliche Installation, manchmal mehr Debugging.

Wenn Sie sich mit Edge TPU beschäftigen möchten, helfen Praxisanleitungen beim Einstieg, z. B. für Pi 5 und Coral-Setup: Konfiguration Coral Edge TPU auf Raspberry Pi 5.

Typische Fehlerquellen und schnelle Problemlösung

Die häufigsten Probleme beim Start sind weniger „KI“ und mehr System- und Datenformat-Themen. Wenn Sie diese Klassiker kennen, sparen Sie viel Zeit:

- Falscher Input-Typ: Modell erwartet uint8, Sie geben float32 (oder umgekehrt). Ergebnis: schlechte Scores oder Fehler.

- Falsche Normalisierung: Manche Modelle erwarten Werte in [0,1], andere in [-1,1] oder rohe Pixelwerte.

- Falsche Farbkanäle: RGB vs. BGR führt zu „funktioniert, aber erkennt nichts“.

- Shape passt nicht: Input-Tensor erwartet z. B. [1,224,224,3], geliefert wird [224,224,3].

- Zu hohe Auflösung: Kamera liefert zu große Frames, Preprocessing wird zum Flaschenhals.

- Thermische Drosselung: Nach einigen Minuten sinkt Performance spürbar, weil die CPU heruntertaktet.

Ein pragmatischer Debug-Ansatz: Lassen Sie sich Input-Details (Shape, dtype) ausgeben, kontrollieren Sie eine Probe des Preprocessings (z. B. ein gespeichertes Bild nach Resize) und messen Sie Zeiten pro Pipeline-Schritt.

Best Practices für produktionsnahe Projekte: Stabilität, Updates, Service-Betrieb

Viele KI-Projekte sollen nicht nur „einmal laufen“, sondern dauerhaft: als Kameraüberwachung, Zählererkennung, Präsenzdetektor oder Smart-Home-Trigger. Dann zählen Stabilität und Wartbarkeit mindestens so stark wie reine FPS.

- Als Dienst betreiben: Starten Sie die Anwendung automatisch beim Boot (z. B. via systemd), inklusive Restart bei Fehlern.

- Logging diszipliniert: Nicht jeden Frame „voll“ loggen; sonst bremst I/O und Speichermedien leiden.

- Konfiguration auslagern: Pfade, Schwellwerte, Modellpfad und Kameraoptionen in eine Config-Datei.

- Watchdog/Healthchecks: Prüfen Sie, ob Kamera-Frames ankommen und Inference valide Ergebnisse liefert.

- Updates geplant: System- und Python-Updates in Wartungsfenstern, besonders wenn ein Projekt „kritisch“ ist.

Modell-Auswahl: Welche Use-Cases eignen sich besonders für den Einstieg?

Für den Einstieg ist es sinnvoll, ein Ziel zu wählen, das schnell sichtbare Ergebnisse liefert. Diese Kategorien funktionieren auf dem Raspberry Pi typischerweise sehr gut, wenn Sie ein passendes Modell wählen und die Auflösung vernünftig halten:

- Bildklassifikation: „Was ist auf dem Bild?“ – schnell, oft mit kleinen Modellen möglich.

- Objekterkennung (leichtgewichtig): „Wo ist ein Objekt?“ – anspruchsvoller, aber sehr beliebt (z. B. Person/Haustier).

- Audio-Trigger: Hotword-ähnliche Erkennung, sofern Modell und Pipeline effizient sind.

- Sensor-Fusion: KI-Ergebnisse plus Sensorwerte (Temperatur, Bewegung) für robuste Entscheidungen.

Wenn Sie Objekterkennung als Einstieg wählen, achten Sie besonders auf Modellgröße und Postprocessing. Viele Anwendungen benötigen weniger „perfekte“ Erkennung als eine stabile, reproduzierbare Erkennung mit klaren Schwellwerten.

Weiterführende Ressourcen (Outbound-Links)

- TensorFlow: tf.lite.Interpreter (API-Dokumentation)

- Google AI Edge: TFLite Interpreter für Python

- tflite-runtime auf PyPI (schlanke Runtime für Inference)

- Raspberry Pi Documentation (System, Interfaces, Best Practices)

- Raspberry Pi Kamera-Dokumentation (Python)

- Picamera2 (libcamera-basierte Python-Bibliothek)

- Adafruit: TFLite Object Recognition auf Raspberry Pi 4/5

- Pi Hut: Coral Edge TPU auf Raspberry Pi 5 einrichten

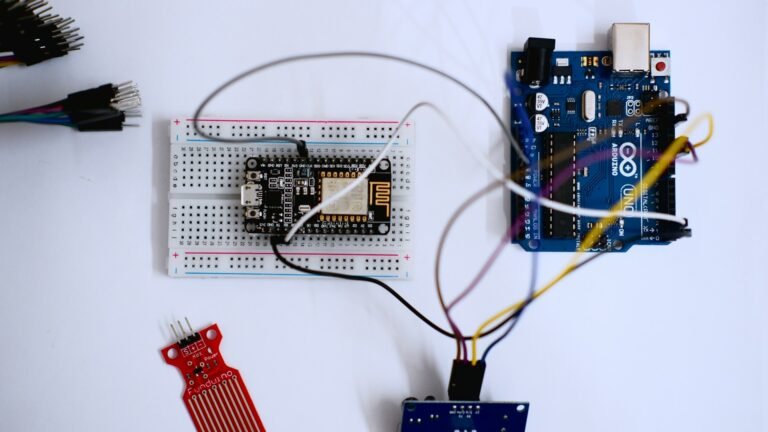

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.