Quanten-Computing und Mikrocontroller wirken auf den ersten Blick wie zwei Welten, die wenig miteinander zu tun haben: Hier hochkomplexe Quantenprozessoren in Laborumgebungen, dort robuste, günstige Embedded-Systeme, die Sensoren auslesen, Motoren steuern und Geräte vernetzen. Dennoch wächst die Schnittmenge. Quanten-Computing und Mikrocontroller treffen sich dort, wo Daten aus der realen Welt entstehen, verarbeitet, abgesichert und an leistungsfähige Rechenressourcen übergeben werden müssen. Denn selbst wenn Quantencomputer künftig bestimmte Probleme deutlich schneller lösen können, bleibt der Mikrocontroller das Arbeitstier am Rand des Netzwerks: Er erfasst Messwerte, steuert Aktoren, trifft lokale Entscheidungen und sorgt für zuverlässige Echtzeitreaktionen. Die spannende Frage lautet daher weniger, ob Quantencomputer Mikrocontroller ersetzen, sondern was auf uns zukommt, wenn Quanten-Computing als zusätzlicher Baustein in Cloud, Forschung und Industrie reifer wird – und welche Folgen das für Firmware, IoT-Sicherheit, Edge-Architekturen und Entwicklerkompetenzen hat.

Warum Quanten-Computing überhaupt relevant für Embedded Systems ist

Mikrocontroller sind für Aufgaben optimiert, die deterministisch, energieeffizient und kostengünstig ablaufen: Regelung, Signalverarbeitung, Kommunikation, einfache KI-Modelle, Sicherheitsfunktionen und Geräteverwaltung. Quantencomputer zielen dagegen auf spezielle Problemklassen ab, etwa Optimierung, Materialsimulation oder bestimmte algebraische Aufgaben, bei denen quantenmechanische Effekte theoretische Vorteile bieten. Das bedeutet: Quanten-Computing wird Embedded-Systeme nicht „ersetzen“, aber es kann Prozesse beeinflussen, in die Mikrocontroller eingebettet sind.

Ein Beispiel ist die industrielle Optimierung: Ein Mikrocontroller erfasst Prozessdaten und steuert Maschinen, während ein Backend – perspektivisch auch mit Quantenbeschleunigung – Optimierungsparameter berechnet und zurückliefert. Ein anderes Beispiel ist Kryptografie: Mikrocontroller müssen Daten sicher speichern und übertragen. Wenn Quantencomputer bestimmte Kryptoverfahren angreifen können, müssen Embedded-Geräte auf neue, „post-quanten-sichere“ Verfahren umgestellt werden.

Quantencomputer vs. Mikrocontroller: Grundlagen verständlich abgegrenzt

Ein Mikrocontroller arbeitet klassisch binär: Bits sind 0 oder 1. Ein Quantencomputer nutzt Qubits, die in Superpositionen existieren können, und verschränkt Qubits, um bestimmte Rechenstrukturen abzubilden. In der Praxis heißt das: Quantencomputer sind nicht einfach „schneller“, sondern anders. Sie bringen Vorteile nur bei geeigneten Algorithmen und unter bestimmten Bedingungen. Außerdem sind Quantencomputer derzeit aufwändig in Betrieb, benötigen spezielle Kühlung oder andere physikalische Umgebungen und werden typischerweise als Cloud-Ressource angeboten.

Wichtig für die Praxis: Die Arbeitsaufteilung bleibt

Selbst wenn Quantenhardware in Zukunft effizienter wird, bleiben Mikrocontroller als Schnittstelle zur Realität unverzichtbar. Sensoren, Bus-Systeme, Echtzeit-Interrupts, PWM, Stromsparmodi oder Safety-Funktionen sind Mikrocontroller-Domänen. Quanten-Computing wird eher „dahinter“ stattfinden, als spezialisierter Rechenbeschleuniger für ausgewählte Aufgaben. Für Entwickler ist das eine gute Nachricht: Die Embedded-Welt bleibt relevant, erweitert sich aber um neue Integrations- und Sicherheitsanforderungen.

Welche Anwendungen könnten Quantencomputer realistisch beeinflussen?

Die Diskussion um Quanten-Computing ist oft entweder übertrieben euphorisch oder übermäßig skeptisch. Sinnvoll ist ein differenzierter Blick auf Anwendungsfelder, bei denen Quantenmethoden langfristig Nutzen bringen könnten und in denen Embedded-Systeme eine Rolle spielen.

- Optimierung in Logistik und Produktion: Routenplanung, Scheduling, Ressourcenverteilung – Mikrocontroller liefern Statusdaten, Backend optimiert Abläufe.

- Material- und Chemiesimulation: Schnellere Simulation kann neue Batteriematerialien, Sensorbeschichtungen oder Halbleiterprozesse ermöglichen, was wiederum Mikrocontroller-Hardware indirekt beeinflusst.

- Maschinelles Lernen (hybrid): Quantenunterstützte Methoden könnten für spezielle ML-Teilprobleme relevant werden, während Mikrocontroller TinyML lokal ausführen.

- Sicherheitsanalyse und Kryptografie: Das ist der direkteste Einfluss auf Mikrocontroller-Firmware, weil kryptografische Verfahren angepasst werden müssen.

Wer sich einen Überblick über Quantenplattformen verschaffen möchte, findet gute Einstiege bei IBM Quantum und bei Googles Forschungsseite Google Quantum AI.

Das wahrscheinlich wichtigste Thema: Post-Quantum-Kryptografie für Mikrocontroller

Für Embedded-Systeme ist Sicherheit nicht optional. Viele Geräte laufen Jahre im Feld, oft mit begrenztem Update-Zyklus. Wenn Quantencomputer künftig bestimmte heute verbreitete Public-Key-Verfahren schwächen oder brechen können, entsteht ein konkreter Handlungsdruck: Schlüsselmanagement, Firmware-Update-Mechanismen, Geräteidentität und sichere Kommunikation müssen auf post-quanten-sichere Verfahren umgestellt werden.

Hierbei geht es weniger um Symmetrie als um asymmetrische Verfahren. Symmetrische Kryptografie (z. B. AES) gilt im quantenrelevanten Kontext eher als „skalierbar“ über längere Schlüssel, während klassische Public-Key-Verfahren wie RSA oder ECC im Fokus der Umstellung stehen. In der Praxis heißt das: Zertifikate, TLS-Handshakes, Signaturen für OTA-Updates und Gerätezertifikate sind zentrale Baustellen.

Warum PQC Embedded besonders herausfordert

Post-Quantum-Kryptografie (PQC) bringt oft größere Schlüssel, größere Signaturen oder höhere Rechen- und Speicherlast mit sich. Genau das ist für Mikrocontroller kritisch: Flash und RAM sind begrenzt, ebenso Taktfrequenz und Energie. Daher wird PQC im Embedded-Kontext nicht nur eine „Algorithmuswahl“, sondern eine Systemdesign-Frage: Welche Sicherheitsziele sind nötig? Wo läuft welche Kryptografie? Welche Teile können in sichere Elemente (Secure Elements) ausgelagert werden? Wie wird OTA signiert und verifiziert?

Als Referenz für Standardisierung und technische Einordnung ist das NIST-Programm zur Post-Quantum-Kryptografie eine der wichtigsten Quellen. Für Entwickler ist außerdem die praktische Dokumentation von Kryptobibliotheken relevant, die PQC implementieren oder vorbereiten.

Hybrid-Architekturen: Edge bleibt, Quantum kommt als Service

Das wahrscheinlichste Zukunftsbild ist ein hybrides: Mikrocontroller bleiben am Edge, während Quanten-Computing als Cloud-Service oder als Teil eines Rechenzentrums verfügbar ist. Embedded-Geräte kommunizieren dann nicht direkt mit Quantenhardware, sondern mit einem Orchestrierungssystem, das entscheidet, ob ein Problem klassisch, mit GPU/TPU oder quantum-unterstützt gelöst wird.

Für Maker und Unternehmen heißt das: Quanten-Computing ist weniger ein Hardwarethema „am Board“, sondern ein Architekturthema. Typische Kommunikationsmuster bleiben: MQTT/HTTP/gRPC, lokale Gateways, Edge-Server. Der Unterschied liegt darin, dass bestimmte Backend-Services neue Rechenoptionen erhalten. Ein praxisnaher Einstieg in Cloud-Angebote ist zum Beispiel Azure Quantum.

Was der Mikrocontroller in solchen Architekturen leisten muss

Auch in einer Quanten-Zukunft bleibt der Mikrocontroller verantwortlich für Datenqualität und Robustheit. Quantenalgorithmen sind in der Regel empfindlich gegenüber falschen Eingabedaten oder schlecht konditionierten Problemen. Das bedeutet: Vorverarbeitung, Plausibilitätsprüfungen, Kalibrierung, Zeitstempelung und ggf. lokale Aggregation werden wichtiger. Gleichzeitig steigt die Bedeutung von sicheren Kommunikationskanälen, weil Eingabe- und Ergebnisdaten geschäftskritisch sein können.

Quanten-Sensorik: Neue Messprinzipien, neue Embedded-Schnittstellen

Ein weniger beachteter, aber potenziell sehr relevanter Bereich sind quantenbasierte Sensoren. Hier geht es nicht um Quantencomputer, sondern um Sensorik, die quantenphysikalische Effekte nutzt, um extrem präzise Messungen zu ermöglichen – etwa bei Magnetfeldern, Gravitation, Zeitmessung oder bestimmten Materialeigenschaften. Solche Sensoren könnten in Industrie, Medizintechnik oder Navigation an Bedeutung gewinnen.

Was hat das mit Mikrocontrollern zu tun? Sehr viel: Sensoren müssen angebunden, ausgelesen, gefiltert und in Systeme integriert werden. Selbst wenn der Sensor an sich „quantum“ ist, endet das Signal am Ende in einer Schnittstelle, die ein Embedded-System bedienen muss. Das kann bedeuten: neue Interfaces, andere Datenraten, strengere Anforderungen an Timing oder Kalibrierung.

Quanten-Computing in der Produktentwicklung: Indirekte Auswirkungen auf Mikrocontroller

Selbst wenn Ihr Mikrocontroller-Projekt nie direkt mit Quantenhardware interagiert, kann Quanten-Computing die Technologie indirekt beeinflussen. Wenn Materialsimulationen effizienter werden, könnten neue Halbleitermaterialien, bessere Batterietechnologien oder optimierte Leiterplattenmaterialien entstehen. Auch Designprozesse – etwa die Optimierung von Antennenlayouts, Filterdesigns oder thermischen Eigenschaften – könnten profitieren, wenn neue Simulationsmethoden verfügbar werden.

Für Entwickler bedeutet das: Die Toollandschaft wird breiter, nicht unbedingt komplizierter. Mikrocontroller-Design bleibt ein Zusammenspiel aus Elektronik, Firmware, EMV, Mechanik und Sicherheit. Quanten-Computing könnte Teile davon in Forschung und industrieller Entwicklung beschleunigen, ohne dass der Embedded-Alltag plötzlich „quantisch“ wird.

Entwickler-Skills: Was sollten Maker und Profis heute lernen?

Die meisten Embedded-Entwickler müssen nicht Quantenphysik studieren, um zukunftsfähig zu bleiben. Entscheidend ist das Verständnis hybrider Systeme und moderner Sicherheitsanforderungen. Wer sich früh positionieren will, profitiert von einem soliden Fundament in Kryptografie, Netzwerkarchitektur und Softwarequalität.

- Kryptografie-Grundlagen: Schlüsselmanagement, Signaturen, Zertifikate, sichere Bootchains, OTA-Absicherung.

- Edge-Architekturen: Gateways, sichere Protokolle, Datenpipeline, Offline-Strategien.

- Performance und Ressourcen: Speicherprofile, Laufzeitverhalten, Energieverbrauch – besonders relevant bei PQC.

- Testing und Wartbarkeit: reproduzierbare Builds, CI/CD für Firmware, Telemetrie und Diagnostik.

Für den Einstieg in Quantenprogrammierung auf konzeptioneller Ebene – ohne Anspruch, sofort produktionsreif zu entwickeln – ist Qiskit eine bekannte Lernplattform, weil sie anschauliche Beispiele und eine zugängliche Toolchain bietet.

Was ist kurzfristig realistisch – und was bleibt Zukunftsmusik?

In der praktischen Planung hilft eine Zeithorizont-Perspektive. Kurzfristig (in der Embedded-Welt oft: die nächsten Produktzyklen) ist die wichtigste Veränderung die Vorbereitung auf post-quanten-sichere Kryptografie und eine generelle Professionalisierung von Update- und Sicherheitsketten. Mittel- bis langfristig kann Quanten-Computing als Backend-Service in Branchenprozessen wachsen. Sehr langfristig sind disruptive Veränderungen möglich, aber im Embedded-Kontext wird sich vieles evolutionär entwickeln.

Konkrete Punkte, die heute schon relevant sein können

- Krypto-Agilität: Systeme so entwerfen, dass Algorithmen austauschbar sind (statt fest „einzubrennen“).

- Update-Fähigkeit: Geräte so bauen, dass Sicherheitsupdates realistisch verteilt werden können.

- Risikobewertung: Welche Daten müssen wie lange vertraulich bleiben? Daraus ergibt sich, wie dringend PQC ist.

- Hardware-Reserven: Bei neuen Designs ausreichend Flash/RAM einplanen, um künftige Sicherheitsanforderungen tragen zu können.

Wie Mikrocontroller-Hersteller reagieren könnten

Wenn PQC und Sicherheitsanforderungen breiter ankommen, werden Mikrocontroller-Ökosysteme voraussichtlich stärker auf integrierte Security setzen: Hardwarebeschleuniger, sichere Speicherbereiche, bessere True-Random-Number-Generatoren, Secure Boot als Standard und Tooling für Zertifikatsketten. Auch Secure Elements und TPM-ähnliche Bausteine könnten häufiger in Maker-freundlichen Designs auftauchen, weil sie den Aufwand in der Firmware reduzieren.

Das bedeutet nicht zwangsläufig höhere Komplexität für Einsteiger, sondern eher „mehr Standardisierung“: Hersteller-SDKs, Beispielprojekte und Referenzdesigns werden Sicherheitsketten häufiger als Default abbilden. Entscheidend ist, dass Entwickler verstehen, was diese Defaults leisten – und wo ihre Grenzen sind.

Quanten-Computing im Alltag: Was sich für Maker-Projekte ändern kann

Für Maker ist die wichtigste Botschaft: Quanten-Computing wird Ihre Projekte nicht über Nacht umkrempeln. Die meisten DIY-Projekte profitieren weiterhin von guter Sensorik, solider Stromversorgung, sauberem Prototyping und zuverlässiger Software. Was sich aber schrittweise ändern kann, sind die „Rahmenbedingungen“: mehr Fokus auf Sicherheit, längere Lebenszyklen, höhere Anforderungen an Update-Mechanismen und eine stärkere Verzahnung mit Cloud-Services, die auch neue Rechenmodelle integrieren können.

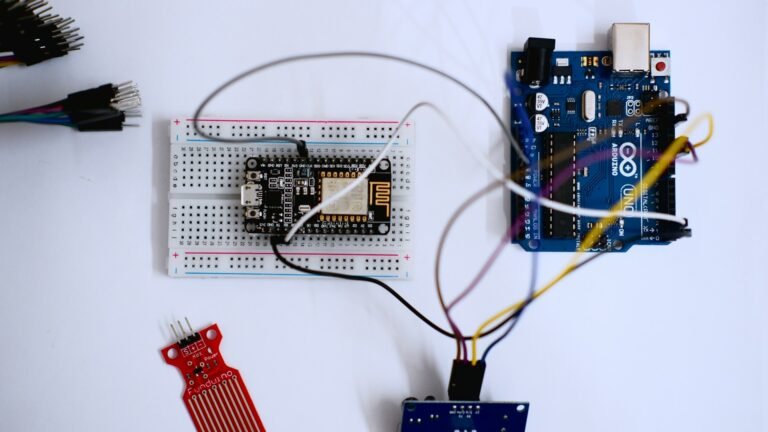

Ein realistisches Maker-Szenario ist daher nicht „ESP32 + Quantenchip auf dem Breadboard“, sondern „ESP32/STM32 als Edge-Gerät + Backend-Service“, der für ausgewählte Aufgaben Quantenressourcen nutzt. Und parallel: Geräte, die durch PQC-Umstellungen sicher bleiben müssen.

Orientierung und seriöse Informationsquellen

Weil Quanten-Computing ein stark diskutiertes Feld ist, lohnt es sich, auf belastbare Quellen zu setzen. Für Standardisierung und Sicherheitsfragen ist das NIST besonders relevant, für praktische Plattformzugänge sind etablierte Anbieter hilfreich, und für Open-Source-Ökosysteme bieten große Projekte gute Lernpfade.

- NIST-Programm zur Post-Quantum-Kryptografie

- IBM Quantum Plattform und Lernressourcen

- Google Quantum AI

- Azure Quantum

- Qiskit (Open-Source-Framework für Quantenexperimente)

Wer „Quanten-Computing und Mikrocontroller“ sinnvoll zusammendenken will, konzentriert sich am besten auf das, was in Embedded-Systemen wirklich zählt: robuste Schnittstellen zur realen Welt, sichere Identitäten, updatefähige Geräte und Architekturkompetenz. Quanten-Computing ergänzt dieses Bild als spezialisierte Rechenressource – und genau darin liegt die realistische Perspektive dessen, was auf uns zukommt.

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.