Die STM32 Floating Point Unit (FPU) ist für viele Embedded-Projekte der entscheidende Unterschied zwischen „es läuft irgendwie“ und „es läuft schnell, stabil und sauber skalierbar“. Sobald Sie Regelungen, Filter, Sensorfusion, Audioverarbeitung, Motorsteuerung oder Machine-Learning-Feature-Extraktion umsetzen, spielt Mathematik eine zentrale Rolle. Fließkomma-Rechnung (Floating Point) ist dabei oft die natürlichste Darstellungsform: Messwerte, Skalierungen, Einheitenumrechnungen und kontinuierliche Modelle lassen sich damit direkt und verständlich abbilden. Ohne FPU muss ein Mikrocontroller viele Fließkomma-Operationen in Software emulieren – das kostet Zeit, Strom und oft auch Codegröße. Mit FPU hingegen können viele Operationen hardwarebeschleunigt ausgeführt werden, was Latenzen reduziert und Echtzeitbudgets entspannt. Gleichzeitig ist die FPU kein „Wundermittel“: Sie muss korrekt aktiviert sein, Ihr Compiler muss passende Einstellungen nutzen, und Sie sollten wissen, wann Single Precision genügt, wann Double Precision teuer wird und wie Sie Cache, DMA und mathematische Bibliotheken sinnvoll kombinieren. Dieser Artikel erklärt verständlich, wie die FPU in STM32-Mikrocontrollern arbeitet, wie Sie sie richtig nutzen und welche Best Practices in der Praxis wirklich Performance bringen.

Was ist eine FPU und warum ist sie im Embedded-Bereich so wichtig?

Eine Floating Point Unit ist eine Hardwareeinheit, die Fließkomma-Operationen wie Addition, Subtraktion, Multiplikation, Division sowie oft auch spezielle Operationen (z. B. Multiply-Accumulate) direkt im Prozessor ausführt. Im Embedded-Umfeld ist das relevant, weil viele Anwendungen kontinuierliche Größen verarbeiten: Spannung, Strom, Beschleunigung, Winkel, Temperatur, Druck, Drehzahl oder Frequenz. Diese Größen sind selten ganze Zahlen, und sie müssen häufig skaliert, gefiltert oder in Modellen verarbeitet werden.

- Regelungstechnik: PID-Regler, Zustandsregler, Beobachter, digitale Filter.

- Signalverarbeitung: FIR/IIR-Filter, FFT, Spektralanalyse, Demodulation.

- Sensorfusion: IMU-Daten (Gyro/Accel/Mag) zu Orientierung und Geschwindigkeit verknüpfen.

- Numerik und Kalibrierung: Linearisierung, Temperaturkompensation, Polynomapproximationen.

Ohne FPU werden viele dieser Berechnungen entweder extrem langsam oder müssen als Fixed-Point (Ganzzahl mit Skalierung) umgesetzt werden. Fixed-Point kann sehr effizient sein, erhöht aber den Implementierungsaufwand und das Risiko von Überläufen, Rundungsfehlern und Wartungsproblemen. Eine FPU ermöglicht Ihnen, schneller zu prototypen und dennoch performant zu bleiben – sofern Sie die Rahmenbedingungen beachten.

Welche STM32 haben eine FPU? Cortex-M4F, M7 und moderne Kerne

Die FPU ist bei STM32 nicht „immer dabei“. Sie hängt vom CPU-Kern ab. Viele STM32 mit Cortex-M4 sind als M4F-Varianten mit Single-Precision-FPU ausgeführt. Cortex-M7 hat typischerweise ebenfalls eine Single-Precision-FPU, kombiniert mit hoher Taktfrequenz und guter DSP-Eignung. Andere Kerne (z. B. Cortex-M33 in bestimmten Familien) können ebenfalls FPU-Optionen besitzen, abhängig von konkreter MCU-Konfiguration.

- Cortex-M4F: Single Precision (32 Bit), gute Balance aus Leistung und Energiebedarf.

- Cortex-M7: Single Precision plus hohe Performance, oft ideal für DSP, Networking und anspruchsvolle Echtzeit.

- Wichtig: Double Precision (64 Bit) ist in vielen Cortex-M-Varianten nicht als echte Hardware-FPU vorhanden und wird häufig (teilweise) softwarebasiert.

Für CPU-Grundlagen und FPU-Ausstattung lohnt ein Blick in die offiziellen Arm-Übersichten, etwa zu Cortex-M4 und Cortex-M7. Für STM32-spezifische Einordnung ist die ST-Übersicht zu STM32-Mikrocontrollern ein guter Einstiegspunkt.

IEEE-754 im Alltag: Single Precision verstehen, ohne sich zu verlieren

Die meisten STM32-FPUs arbeiten mit IEEE-754 Single Precision (32 Bit). Diese Darstellung teilt ein Fließkommawort grob in Vorzeichen, Exponent und Mantisse. Das ist wichtig, um die Grenzen der Genauigkeit zu verstehen. Single Precision liefert typischerweise rund 6–7 dezimale Stellen Präzision. Für viele Sensor- und Regelungsaufgaben reicht das völlig aus, aber nicht für jede numerische Problemklasse.

Vereinfacht lässt sich ein normalisierter IEEE-754-Wert so darstellen:

Hier steht

Rundungsfehler und numerische Stabilität in Embedded-Systemen

Ein häufiger Irrtum lautet: „Float ist ungenau, also besser gar nicht verwenden.“ In Wahrheit sind viele Probleme gut beherrschbar, wenn Sie numerisch stabile Methoden wählen. Beispiel: Subtraktion zweier nahezu gleicher Zahlen kann zu Verlust signifikanter Stellen führen (katastrophale Auslöschung). In Regelungen und Filtern lässt sich das oft vermeiden, indem man skalierte Zustandsgrößen nutzt, geeignete Filterstrukturen wählt oder Summationen in sinnvoller Reihenfolge durchführt.

Performance: Warum die FPU schneller ist, aber nicht automatisch immer „am schnellsten“

Die FPU beschleunigt Fließkomma-Arithmetik, aber die reale Performance hängt an mehreren Faktoren: Pipeline, Speicherzugriffe, Compiler-Optimierung und Bibliotheksimplementierungen. Ein typischer Engpass ist nicht die FPU selbst, sondern das Holen und Speichern von Operanden. Bei großen Arrays (z. B. FFT-Buffern) limitiert oft die Speicherbandbreite oder Cache-Miss-Rate.

- Compute-bound: Wenn Ihre Schleife fast nur rechnet, bringt die FPU maximalen Gewinn.

- Memory-bound: Wenn Datenzugriffe dominieren, hilft Optimierung von Speicherlayout, Cache und DMA oft mehr.

- Funktionsaufrufe: Viele kleine Mathe-Funktionen (sin/cos) können teuer sein; Lookup oder Approximationen sind manchmal sinnvoll.

FMA und Multiply-Accumulate: Warum Filter profitieren

Viele DSP-Algorithmen basieren auf Multiply-Accumulate (MAC): y += a * b. Wenn der Kern dafür effiziente Pfade hat (und Bibliotheken wie CMSIS-DSP das ausnutzen), können FIR/IIR-Filter und Vektoroperationen massiv beschleunigt werden. Für optimierte Routinen ist CMSIS-DSP eine der wichtigsten Referenzen, weil sie Vektor-/Matrixfunktionen und Filter für Cortex-M optimiert bereitstellt.

Compiler- und Projektsetup: Damit die FPU wirklich genutzt wird

Ein überraschend häufiger Grund für „FPU ist langsam“ ist: Die FPU wird gar nicht genutzt. Dann erzeugt der Compiler Software-Emulation oder mischt Soft/Hard-Float-ABI falsch. In STM32-Projekten sollten Sie daher die Toolchain-Einstellungen gezielt prüfen:

- FPU-Typ auswählen: z. B. „Single Precision“ passend zum Kern.

- ABI festlegen: Hard-Float (wenn FPU vorhanden und gewünscht), damit Parameter in FPU-Registern übergeben werden.

- Optimierungsstufe: für Performance meist -O2 oder -O3 (mit Bedacht), Debug-Builds sind oft deutlich langsamer.

- Bibliotheken: sicherstellen, dass die verwendete libc/libm zur ABI passt.

In STM32CubeIDE und anderen GCC-basierten Umgebungen entspricht das häufig Einstellungen wie -mfpu=fpv4-sp-d16 (M4F) oder -mfpu=fpv5-sp-d16 (M7) und -mfloat-abi=hard. Die konkreten Optionen hängen vom Core ab; entscheidend ist die Konsistenz: Alle Objekte und Libraries müssen kompatibel gebaut sein.

FPU in Interrupts und Kontextwechseln

Wenn Sie ein RTOS verwenden oder viele Interrupts nutzen, spielt das Kontext-Handling eine Rolle. Fließkommaregister müssen bei Kontextwechseln ggf. gesichert werden. Moderne Cortex-M unterstützen dafür „Lazy Stacking“, wodurch FPU-Register nur dann gesichert werden, wenn sie tatsächlich genutzt wurden. Das reduziert Overhead, aber Sie sollten wissen, dass „FPU in ISR“ nicht kostenlos ist. In harten Echtzeitpfaden kann es sinnvoll sein, Float-Berechnungen aus sehr hochpriorisierten ISRs herauszuhalten und stattdessen per DMA/Buffering in Tasks zu verarbeiten.

Float vs. Fixed-Point: Wann welche Strategie sinnvoll ist

Auch mit FPU ist Fixed-Point nicht „obsolet“. Es gibt klare Situationen, in denen Fixed-Point weiterhin die bessere Wahl sein kann: extrem harte Echtzeitbudgets, sehr hohe Sample-Raten, sehr kleine MCUs ohne FPU oder sicherheitskritische Anforderungen, in denen deterministische Rundung und Sättigung wichtig sind. Dennoch ist Float mit FPU häufig der beste Kompromiss aus Entwicklungszeit, Wartbarkeit und Performance.

- Float (mit FPU): schnell implementiert, gut lesbar, in vielen Fällen ausreichend genau.

- Fixed-Point: maximal effizient, aber komplexer; Skalierungen und Sättigung müssen sauber geplant werden.

- Hybrid: Datenaufnahme und IO in Integer, Kernalgorithmen in Float, Output wieder skaliert.

Skalierung als Brücke: Integer rein, Float raus

Sensoren liefern oft ADC-Rohwerte als Integer. Eine übliche Praxis ist, einmal sauber zu skalieren und dann im Float-Raum zu arbeiten. Beispiel: Ein 12-Bit-ADC liefert Werte 0…4095, die auf Spannung 0…Vref gemappt werden. Das lässt sich mathematisch schlicht ausdrücken:

Mit FPU ist diese Umrechnung schnell und leicht wartbar, und Sie vermeiden komplizierte Fixed-Point-Skalierungsfehler an vielen Stellen im Code.

Teure Funktionen: sin, cos, sqrt und warum Approximationen manchmal gewinnen

Viele Projekte scheitern nicht an Addition oder Multiplikation, sondern an „transzendenter Mathematik“: sin(), cos(), atan2(), exp(), log(). Diese Funktionen sind in der Standardbibliothek oft relativ teuer, weil sie hohe Genauigkeit anstreben und viele Sonderfälle korrekt abdecken. In Echtzeitsystemen kann es sinnvoll sein, das zu optimieren.

- Lookup-Tabellen: sehr schnell, aber Speicherbedarf und Interpolation beachten.

- Polynomapproximation: guter Trade-off aus Genauigkeit und Geschwindigkeit.

- CORDIC (falls vorhanden): manche MCUs bieten CORDIC-Peripherie für trigonometrische Funktionen.

- Algorithmus ändern: z. B. Quaternionen statt Euler-Winkel, um trigonometrische Aufrufe zu reduzieren.

Genauigkeit passend zur Anwendung definieren

Ein entscheidender Best-Practice ist, Genauigkeit als Anforderung zu formulieren: Brauchen Sie wirklich 1e-9 Genauigkeit in sin() für eine Motorregelung? Oder reichen 1e-4? In Embedded-Systemen sind Messrauschen und Sensorfehler oft größer als der numerische Fehler. Wenn Sie das sauber analysieren, können Sie Mathe-Funktionen oft deutlich beschleunigen, ohne die Systemqualität zu verschlechtern.

FPU und DSP zusammen: CMSIS-DSP als Performance-Booster

Wer „schnelle Mathematik auf dem Chip“ wirklich ausreizen will, sollte nicht jede Vektoroperation selbst schreiben. Optimierte Bibliotheken nutzen typische Muster wie Loop Unrolling, SIMD/DSP-Instruktionen und effiziente Speicherzugriffe. CMSIS-DSP bietet u. a.:

- Vektoroperationen: Add, Sub, Mul, Scale, Dot Product.

- Filter: FIR, IIR (biquad), LMS und mehr.

- FFT/DFT: schnelle Transformationsroutinen für verschiedene Längen.

- Matrixfunktionen: Multiplikation, Inversion (je nach Typ und Größe).

Gerade auf Cortex-M4F und M7 lassen sich damit erhebliche Geschwindigkeitsvorteile erreichen, ohne die Wartbarkeit zu verlieren. Die Dokumentation unter CMSIS-DSP hilft, die passende Funktion für den jeweiligen Datentyp und das gewünschte Verhalten zu wählen.

Praktische Anwendungsbeispiele: Wo die STM32 FPU sofort spürbar ist

Die Wirkung der FPU zeigt sich besonders in Anwendungen mit vielen Operationen pro Zeiteinheit oder mit komplexen Modellen:

- PID-Regler mit Anti-Windup: saubere Floating-Point-Implementierung ist robust und gut parametrierbar.

- IMU-Sensorfusion: Quaternion-Update, Normierung, Filterung in Float ist deutlich einfacher als Fixed-Point.

- Audio-Filterketten: mehrere IIR-Biquads in Echtzeit sind mit FPU und DSP-Libs gut machbar.

- Kalibrierung und Kompensation: Polynomkorrekturen oder Temperaturmodelle lassen sich direkt abbilden.

- Feature-Extraktion: RMS, Peak, Spektralenergie für Condition Monitoring oder TinyML-Pipelines.

Regelung: Diskreter PID als anschaulicher Einstieg

Ein diskreter PID-Regler (vereinfacht) berechnet eine Stellgröße aus Fehler

In der Embedded-Praxis ersetzen Sie Integral und Ableitung durch diskrete Summen/Differenzen. Der Vorteil der FPU: Sie können Parameter in physikalischen Einheiten halten und die Regelung leicht nachführen, ohne sich in Fixed-Point-Skalierungsdetails zu verlieren.

Typische Fallstricke: Warum Float-Code manchmal trotzdem langsam oder falsch wirkt

- FPU nicht aktiviert oder Soft-Float gebaut: führt zu massivem Performanceverlust, obwohl „Float“ im Code steht.

- Double statt float: unbewusst „double“ verwenden (z. B. durch Literale wie 0.1 statt 0.1f) kann viel kosten.

- Zu viele Library-Calls: sin/cos/atan2 in hoher Rate ohne Optimierung kann Echtzeit sprengen.

- Cache/DMA-Probleme: falsche Buffer-Attribute oder fehlende Cache-Operationen erzeugen scheinbar zufällige Fehler.

- Numerische Instabilität: ungünstige Formeln, schlechte Skalierung oder fehlende Sättigung in Integratoren.

Double-Literale und implizite Typkonvertierung

Ein sehr häufiger Performance-Fußangriff in C/C++: Sie schreiben float x = 0.1; und der Compiler behandelt 0.1 als double-Literal, konvertiert dann nach float. In Hot-Loops summiert sich das. Nutzen Sie konsequent 0.1f und achten Sie darauf, dass Zwischenwerte nicht automatisch auf double „hochgezogen“ werden. Ebenso wichtig: Wählen Sie Bibliotheksfunktionen passend zum Datentyp (z. B. sinf statt sin), wenn verfügbar.

Best Practices: So holen Sie aus der STM32 FPU in realen Projekten das Maximum heraus

- Toolchain konsistent konfigurieren: FPU-Typ und Hard-Float-ABI korrekt setzen, Libraries passend link-en.

- Float bewusst verwenden: float statt double, Literale mit „f“, Funktionsvarianten (sinf, cosf) nutzen.

- Algorithmen vektorisieren: wo möglich CMSIS-DSP nutzen, statt per Hand zu optimieren.

- Memory-Layout planen: große Arrays cachefreundlich, DMA-Puffer korrekt (MPU/Caches), Hot-Daten in schnellen Regionen.

- Echtzeitbudget messen: Timing nicht schätzen, sondern mit Zählern/Trace messen; Worst-Case ist entscheidend.

- Mathe-Funktionen prüfen: teure Funktionen sparsam einsetzen oder approximieren, wenn die Anwendung es erlaubt.

Für die praktische Entwicklungsumgebung und viele Beispielprojekte sind die ST-Tools rund um STM32CubeIDE und die STM32Cube-Pakete der jeweiligen Serie hilfreich, weil sie typische Startup- und Build-Einstellungen bereitstellen und viele Peripherie-Beispiele enthalten. Wenn Sie die FPU korrekt aktivieren, float bewusst einsetzen und Bibliotheken wie CMSIS-DSP nutzen, wird „schnelle Mathematik auf dem Chip“ nicht nur ein Schlagwort, sondern eine messbare Eigenschaft Ihres STM32-Systems.

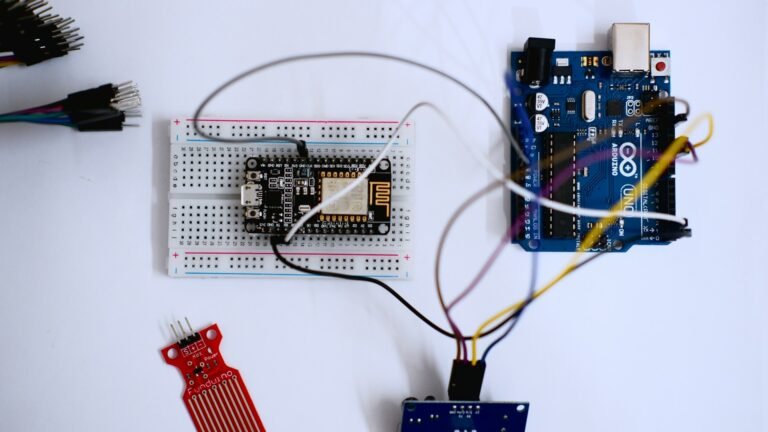

IoT-PCB-Design, Mikrocontroller-Programmierung & Firmware-Entwicklung

PCB Design • Arduino • Embedded Systems • Firmware

Ich biete professionelle Entwicklung von IoT-Hardware, einschließlich PCB-Design, Arduino- und Mikrocontroller-Programmierung sowie Firmware-Entwicklung. Die Lösungen werden zuverlässig, effizient und anwendungsorientiert umgesetzt – von der Konzeptphase bis zum funktionsfähigen Prototyp.

Diese Dienstleistung richtet sich an Unternehmen, Start-ups, Entwickler und Produktteams, die maßgeschneiderte Embedded- und IoT-Lösungen benötigen. Finden Sie mich auf Fiverr.

Leistungsumfang:

-

IoT-PCB-Design & Schaltplanerstellung

-

Leiterplattenlayout (mehrlagig, produktionstauglich)

-

Arduino- & Mikrocontroller-Programmierung (z. B. ESP32, STM32, ATmega)

-

Firmware-Entwicklung für Embedded Systems

-

Sensor- & Aktor-Integration

-

Kommunikation: Wi-Fi, Bluetooth, MQTT, I²C, SPI, UART

-

Optimierung für Leistung, Stabilität & Energieeffizienz

Lieferumfang:

-

Schaltpläne & PCB-Layouts

-

Gerber- & Produktionsdaten

-

Quellcode & Firmware

-

Dokumentation & Support zur Integration

Arbeitsweise:Strukturiert • Zuverlässig • Hardware-nah • Produktorientiert

CTA:

Planen Sie ein IoT- oder Embedded-System-Projekt?

Kontaktieren Sie mich gerne für eine technische Abstimmung oder ein unverbindliches Angebot. Finden Sie mich auf Fiverr.